Riemannsche Vermutung – Wikipedia

Die Riemannsche Vermutung, Riemannsche Hypothese, Riemannhypothese oder kurz RH trifft eine Aussage über die Verteilung der Primzahlen und ist nach Meinung führender Mathematiker das derzeit bedeutendste ungelöste Problem der reinen Mathematik. Sie wurde erstmals 1859 von Bernhard Riemann in seiner Arbeit Über die Anzahl der Primzahlen unter einer gegebenen Größe in einem Nebensatz formuliert. Nachdem sie bereits im Jahr 1900 von David Hilbert auf seine Liste 23 wichtiger Jahrhundertprobleme gesetzt worden war, wurde sie im Jahr 2000 vom Clay Mathematics Institute in die Liste der sieben Millennium-Probleme der Mathematik aufgenommen. Das Institut in Cambridge (Massachusetts) hat damit ein Preisgeld von einer Million US-Dollar für eine schlüssige Lösung des Problems in Form eines mathematischen Beweises ausgelobt. Hinsichtlich des Auffindens potenzieller Gegenbeispiele existieren in der Preisausschreibung jedoch Sonderregeln, insbesondere dann, wenn diese mit der Rechenkraft moderner Computer erlangt wurden, und keinerlei „tiefere Einsicht“ in das Problem geben können.

Einfach gesprochen sagt die Riemannsche Vermutung aus, dass sich die Folge der Primzahlen „möglichst zufällig“ verhält. Das sollte sich zum Beispiel dadurch äußern, dass die Abfolge der Ereignisse, dass eine Zahl eine gerade Anzahl an Primfaktoren besitzt, wie zum Beispiel , oder eine ungerade Anzahl an Primfaktoren besitzt, wie , für , also nach dem Schema (mit Null Primfaktoren für die 1)

auf lange Sicht ungefähr ein Verhalten aufweist, das auch ein unendlich häufig wiederholter Münzwurf mit „Kopf“ und „Zahl“ realistischerweise haben könnte. Eine Theorie, welche die Riemannsche Vermutung löst und damit eine tiefere Erklärung für diese Zufälligkeit unter den Primzahlen lieferte, könnte daher aus Sicht der Mathematiker ein fundamental neues Verständnis für Zahlen im Allgemeinen nach sich ziehen.

Übersetzt man dies in die Fachsprache der analytischen Zahlentheorie, ist die Riemannsche Vermutung gleichbedeutend mit der Aussage, dass sämtliche komplexe Nullstellen der Riemannschen Zeta-Funktion im sog. kritischen Streifen den Realteil besitzen. Dies ist auch die ursprünglich von Riemann formulierte Version der Vermutung. Die Zeta-Funktion ist eine mathematische Funktion, die Informationen über Primzahlen in ihrem Abbildungsverhalten kodiert: Bereits Leonhard Euler erkannte, dass sie sich als ein Euler-Produkt über die Primzahlen darstellen lässt, sich die Funktionswerte also mit Hilfe der Primzahlen bestimmen lassen. Auf der anderen Seite kann die Zeta-Funktion als ein Produkt über ihre Nullstellen dargestellt werden, ähnlich wie sich Polynome durch ihre Nullstellen faktorisieren lassen, wie etwa . Es liegen also zwei verschiedene Produktdarstellungen derselben Funktion vor. Durch dieses hiervon induzierte Zusammenspiel ergibt sich, dass die Nullstellen Eigenschaften der Primzahlen kodieren, und die Primzahlen wiederum Eigenschaften der Nullstellen. Mathematiker sprechen in diesem Zusammenhang oft von einer „Dualität“.

Es ist schon bekannt und bewiesen, dass die Zeta-Funktion reelle Nullstellen hat, die sogenannten trivialen Nullstellen. Ferner weiß man seit Beginn des 20. Jahrhunderts, dass die Zeta-Funktion unendlich viele nichtreelle Nullstellen mit dem Realteil besitzt. Die Riemannsche Vermutung besagt also, dass es darüber hinaus keine weiteren Nullstellen gibt, d. h., dass alle nichttrivialen Nullstellen der Zeta-Funktion auf einer Geraden in der Zahlenebene parallel zur imaginären Achse liegen. Da die Zeta-Funktion über eine Funktionalgleichung ein elementares Spiegelungsgesetz bezüglich besitzt, ist sie äquivalent dazu, dass sich sämtliche Nullstellen „möglichst weit links“ befinden, wobei „linke Nullstellen“ eine eher gleichmäßige Primzahlverteilung zur Folge haben. Gleichzeitig baut die bloße Existenz von diesen Nullstellen eine natürliche Barriere auf, die so gedeutet werden kann, dass Primzahlen nicht beliebig gleichmäßig, wie etwa „Kopf, Zahl, Kopf, Zahl, Kopf, Zahl, …“, verteilt sein können.

Viele bisher ungelöste Fragestellungen, besonders aus der Zahlentheorie, können mit der Richtigkeit der Riemannschen Vermutung beantwortet werden. Dies betrifft Probleme aus der mathematischen Grundlagenforschung, wie etwa solche der Primzahlverteilung im Umfeld des Primzahlsatzes oder der offenen Goldbachschen Vermutung, als auch der angewandten Mathematik, wie schnelle Primzahltests. Gleichzeitig gilt sie auch als äußerst schwierig zu beweisen. Bisherige Beweisversuche von prominenten Mathematikern scheiterten allesamt. Ein Grund hierfür ist, dass die Menschheit aus Expertensicht bisher nicht über die nötigen mathematischen Werkzeuge verfügt, sie überhaupt angreifen zu können. So gilt es als sehr wahrscheinlich, dass sie nicht mit rein analytischen Mitteln, also durch bloße Untersuchung des „Funktionsterms“ der Zeta-Funktion mittels des Theorieapparats der holomorphen Funktionen, gezeigt werden kann, sondern mit dem Euler-Produkt eine entscheidende arithmetische Komponente mitspielen muss, obwohl dieses im kritischen Streifen nicht mehr konvergiert, was erhebliche Schwierigkeiten mit sich bringt. So gibt es andere Zeta-Funktionen, die der Riemannschen Zeta-Funktion in ihren Eigenschaften sehr stark ähneln, jedoch kein Euler-Produkt besitzen, und bei denen die Riemannsche Vermutung erwiesenermaßen falsch ist.

Durch umfassenden Einsatz von Computern ist es gelungen, die Riemannsche Vermutung für die ersten 10 Billionen Nullstellen der Zeta-Funktion zu bestätigen. Da die Zeta-Funktion jedoch nachweislich unendlich viele nichtreelle Nullstellen besitzt, könnte sie auf diese Weise nur durch Angabe eines expliziten Gegenbeispiels widerlegt, jedoch nicht bewiesen werden. Ein Gegenbeispiel wäre eine Nullstelle im kritischen Streifen mit Realteil ungleich .

Überblick[Bearbeiten | Quelltext bearbeiten]

Im Zentrum der Zahlentheorie, jenes Zweiges der Mathematik, der sich mit den Eigenschaften der natürlichen Zahlen 1, 2, 3, 4, … beschäftigt, stehen die Primzahlen 2, 3, 5, 7, 11, … Diese sind ausgezeichnet durch die Eigenschaft, genau zwei Teiler zu haben, nämlich die 1 und sich selbst. Die 1 ist keine Primzahl. Primzahlen bilden gewissermaßen die Atome der ganzen Zahlen, da sich jede positive ganze Zahl eindeutig multiplikativ in solche zerlegen lässt. Dieses Resultat wird auch als Fundamentalsatz der Arithmetik bezeichnet. Zum Beispiel gilt 21 = 3 · 7 und 110 = 2 · 5 · 11.

Trotz ihrer einfachen Definition ist nach mehreren Jahrtausenden Mathematikgeschichte bis heute kein Muster bekannt, dem sich die Primzahlen in ihrer Folge unterwerfen. Ihre Natur ist eine der bedeutendsten offenen Fragen der Mathematik. Die Riemannsche Vermutung ist eine bis heute nicht bewiesene Aussage über die Verteilung der Primzahlen und motiviert sich aus folgenden Fragestellungen:[1]

- Wie viele Primzahlen 2, 3, 5, 7, 11, … gibt es unter der Zahl 100? Und wie viele sind es unterhalb 10 000 oder 1 000 000?

- Allgemeiner, wie viele Primzahlen gibt es unterhalb einer beliebigen Zahl, etwa X?

Auf den ersten Blick sind dies Fragen sehr spezieller Natur, lediglich die Theorie der Zahlen, bzw. Primzahlen, betreffend. Mathematiker, und später auch Physiker, haben jedoch herausgefunden, dass sie mit einer Vielzahl von Strukturen zusammenhängen, die zahlreiche Felder der mathematischen Wissenschaften verknüpfen. Dies betrifft etwa die Quantenphysik, aber auch die Wahrscheinlichkeitstheorie, jener Zweig der Mathematik, der sich mit dem Zufall befasst. All diese Zusammenhänge sind bisher weder exakt formalisiert, noch verstanden worden. Sie alle münden jedoch gemeinsam in der Riemannschen Vermutung: Die Primzahlen stehen in einer Dualität[2][3][4] zu einem anderen Typ mathematischer Objekte. Dabei bedeutet Dualität, dass es eine natürliche Paarung zwischen den Primzahlen und diesen anderen Objekten gibt. In etwa übertragen sich Informationen über die Primzahlen zu diesen anderen Objekten, aber auch vice versa kodieren Primzahlen Informationen über ihre „Partnerobjekte“. Bei diesen Objekten handelt es sich wieder um Zahlen. Diese unterteilen sich in zwei Kategorien:

- Bereits Mitte des 19. Jahrhunderts erkannte Bernhard Riemann, dass die negativen geraden Zahlen, also , ein Teil dieser Dualität sind. Man bezeichnet diesen Teil bis heute auch als trivial, da die mathematische Tiefe für dessen Verständnis nicht so hoch ist.

- Die übrigen, nichttrivialen „Dualzahlen“ treten nicht als „Zählzahlen“ in Erscheinung, wie es etwa die Primzahlen 2 und 3 auf der anderen Seite der Dualität noch taten, sondern es handelt sich um bestimmte komplexe Zahlen.

Im Kontrast zu der „völlig willkürlichen Anordnung“ der Primzahlen scheint den nichttrivialen „Dualzahlen“ ein sehr strenges Muster zu Grunde zu liegen: wie alle komplexen Zahlen können sie zunächst auf einer Ebene visualisiert werden, und die Riemannsche Vermutung sagt aus, dass die zu den Primzahlen gehörigen nichttrivialen „Dualzahlen“ innerhalb der Ebene alle auf einer gemeinsamen Geraden platziert sind. Sie tragen demnach vermutlich eine starke geometrische Symmetrie.

Die Gründe, weshalb ein Beweis der Riemannschen Vermutung bahnbrechend für die Mathematik wäre, sind vielseitig: Die geometrische Lage der nichttrivialen „Dualzahlen“ birgt Informationen zu der Verteilung der Primzahlen. Kennt man alle Dualzahlen, so kann damit sogar die exakte Verteilung der Primzahlen rechnerisch beliebig genau rekonstruiert werden (siehe unteres Bild zur Primzahlhäufigkeit). Durch das Dualitätsprinzip gehen also wechselseitig keine Informationen verloren. In theoretischer Hinsicht ließe sich die Lage auf einer gemeinsamen Geraden dadurch interpretieren, dass die Primzahlen möglichst gleichmäßig und damit pseudozufällig verteilt sind. Sie liegen also „alle bereits fest“, jedoch ist es schwierig, dem Verteilungsmuster einfache Notwendigkeiten abzuringen. Zum Beispiel kann in den Primfaktorzerlegungen benachbarter Zahlen, wie etwa

bislang kein notwendiger Zusammenhang erkannt werden. Viele bisher nicht bewiesene Vermutungen der Zahlentheorie würden zudem aus dem Beweis der Riemannhypothese als „Zugabe“ direkt mit folgen. Dazu zählen auch verbesserte Primzahltests, die in der Kryptographie praktische Anwendungen finden.[5] Die Theorie der Riemannschen Vermutung führt darüber hinaus viele Gebiete der Mathematik zusammen. Tut dies eine Theorie, spricht dies für eine Form der Fundamentalität. Beispiel einer solchen fundamentalen Theorie ist der Ende des 20. Jahrhunderts bewiesene Modularitätssatz, der mit elliptische Kurven und Modulformen zwei auf den ersten Blick völlig verschiedene Theorien zusammenbrachte. Ein tieferes Verständnis der Primzahlen könnte auch neue Entwicklungen in der Quantenphysik nach sich ziehen. Wäre die Symmetrie unter den „Dualzahlen“ erfüllt, könnte dieses System zum Beispiel möglicherweise als Quasikristall aufgefasst werden.

Das Phänomen der Dualität lässt sich anhand einer berühmten anderen Zahlenfolge veranschaulichen, der Fibonacci-Folge

Die Folge beginnt per Definition mit 0 und 1, und die Summe der beiden vorherigen Zahlen ergibt stets die folgende Zahl. In der Mathematik bezeichnet man solche Folgen auch als rekursiv. Die Fibonacci-Folge lässt sich damit implizit durch

- und mit

definieren. Die Relation schlägt eine Brücke in die Algebra, wo sie in der Gleichung Ausdruck findet.[Anm. 1] Diese quadratische Gleichung kann durch die Mitternachtsformel gelöst werden, wobei man die Lösungen und erhält. Es ist dabei der negative goldene Schnitt, und dieser wie auch stehen in Dualität zur Fibonacci-Folge. Aus beiden Nullstellen rekonstruiert sich jeder Fibonacci-Wert über die exakte Formel

und aus der Fibonacci-Folge lässt sich andersherum der goldene Schnitt konstruieren durch . Die endliche Rekursion hinter den Fibonacci-Zahlen garantiert eine geringe mathematische Komplexität dieser Folge, und entsprechend „klein“ ist die Menge der „Dualzahlen“ . Die Primzahlen hingegen erfüllen keine endliche Rekursion, und ihre „genaue Zusammensetzung“ ist sehr kompliziert. Auch sie können, unter Ausnutzung der eindeutigen Primfaktorzerlegung natürlicher Zahlen, in einer Funktion kodiert werden. Bei diesem Prozess nimmt die charakteristische Eigenschaft der Primzahlen, die natürlichen Zahlen multiplikativ aufzubauen, eine analoge Rolle ein wie bei der Assoziation der Fibonacci-Folge mit der Funktion . Die durch die Primzahlen gewonnene Funktion ist jedoch um einiges komplizierter als die quadratische Funktion . Man bezeichnet sie als Riemannsche Zeta-Funktion, und ihre Nullstellen sind die zu den Primzahlen gehörigen „Dualzahlen“. Die Zeta-Funktion ist, im Gegensatz zu , keine rationale Funktion, kann also nicht durch eine endliche Abfolge der vier Grundrechenarten (Plus, Minus, Mal und Geteilt) aus dem Eingabewert berechnet werden. Sie hat unendlich viele Nullstellen, und die hohe Komplexität der Primzahlen drückt sich dadurch aus, dass folglich die Menge der „Dualzahlen“ unendlich groß ist.

Der Zahlentheoretiker Don Zagier fasste das Problem auf seiner am 5. Mai 1975 gehaltenen Antrittsvorlesung an der Universität Bonn wie folgt zusammen:

„Es gibt zwei Tatsachen über die Verteilung von Primzahlen […]: Die eine ist, daß die Primzahlen, trotz ihrer einfachen Definition und Rolle als Bausteine der natürlichen Zahlen, zu den willkürlichsten, widerspenstigsten Objekten gehören, die der Mathematiker überhaupt studiert. Sie wachsen wie Unkraut unter den natürlichen Zahlen, scheinbar keinem anderen Gesetz als dem Zufall unterworfen, und kein Mensch kann voraussagen, wo wieder eine sprießen wird, noch einer Zahl ansehen, ob sie prim ist oder nicht. Die andere Tatsache ist viel verblüffender, denn sie sagt just das Gegenteil, daß die Primzahlen die ungeheuerste Regelmäßigkeit aufzeigen, dass sie durchaus Gesetzen unterworfen sind und diesen mit fast peinlicher Genauigkeit gehorchen.“

Notation[Bearbeiten | Quelltext bearbeiten]

Es werden durchweg folgende Bezeichnungen verwendet:

- , , , und bezeichnen die natürlichen, ganzen, rationalen, reellen bzw. komplexen Zahlen.

- Die Notation für asymptotische Beschränktheit durch Landau-Symbole: Es bedeutet , dass (wobei meist ). Analog wird mit gebraucht, und mögliche Abhängigkeiten der absoluten Konstanten werden durch Eintragungen im Index gekennzeichnet. In etwa ist für alle . Ferner bedeutet sogar . Es bezeichnet hierbei den Limes superior.

- Es bezeichnen durchgängig und den Real- bzw. Imaginärteil der komplexen Zahl .

- Wie üblich ist durchgängig der natürliche Logarithmus von , und bzw. die natürliche Exponentialfunktion. Es bezeichnen den Integrallogarithmus und die Primzahl zählende Funktion.

- Es bezeichnet die Riemannsche Zeta-Funktion und die Gammafunktion. Zudem wird mit reellen und geschrieben.

- Es bezeichnen die Liouville-Funktion, die Möbius-Funktion und die Mangoldt-Funktion.

Bekannte Konzepte der Primzahlverteilung[Bearbeiten | Quelltext bearbeiten]

Die Unendlichkeit der Primzahlen[Bearbeiten | Quelltext bearbeiten]

Bereits Euklid konnte zeigen, dass es unendlich viele Primzahlen gibt, weshalb die Liste 2, 3, 5, 7, 11, … aller Primzahlen niemals endet, genauso wie die Liste 1, 2, 3, 4, … aller natürlichen Zahlen niemals endet. Sein Resultat wird als Satz des Euklid bezeichnet.[7]

Der Satz des Euklid ist ein mathematischer Satz; seine Richtigkeit muss daher bewiesen werden. Ein mathematischer Beweis erfolgt durch eine Aneinanderreihung logisch wahrer Argumente, die auf Axiomen oder bereits bewiesenen Sätzen aufbauen. Ein Beweis der Unendlichkeit der Primzahlen kann in etwa so geführt werden:

- Ist eine endliche Anzahl verschiedener Primzahlen gefunden, so bilde man deren Produkt. Anschließend addiere man das Ergebnis mit 1. Die dadurch entstandene Zahl ist nach Konstruktion durch keine Primzahl in der Liste teilbar. Da aber jede Zahl durch eine Primzahl teilbar ist, gibt es neben allen Primzahlen in der Liste eine weitere Primzahl.

Nachvollziehen lässt sich das Verfahren an folgendem Beispiel: Betrachtet man die Liste {2, 5, 11} von Primzahlen, so ist deren Produkt 2 · 5 · 11 = 110 durch 2, 5 und 11 teilbar. Damit kann 110 + 1 = 111 weder durch 2, 5 noch 11 teilbar sein, also gibt es eine weitere Primzahl, die sich von 2, 5 und 11 unterscheidet. In etwa teilt die Primzahl 3 die Zahl 111, und es gilt 111 = 3 · 37. Selbstverständlich ist die Listenlänge von drei Zahlen in diesem Beispiel willkürlich; man hat zum Beispiel

- 2 · 3 · 5 · 7 · 11 · 13 + 1 = 59 · 509,

und weder die Primzahlen 59 noch 509 sind in der Liste {2, 3, 5, 7, 11, 13} enthalten. Das Argument zeigt also, dass jede noch so lange Liste von Primzahlen unvollständig ist. Damit muss es unendlich viele Primzahlen geben.

Die Riemannsche Vermutung gibt eine quantitative Vorstellung von der Verteilung der Primzahlen, die über das bloße Wissen um deren Unendlichkeit sehr weit hinausgeht.

Eine Entdeckung Eulers[Bearbeiten | Quelltext bearbeiten]

Im Laufe der Zeit wurden zahlreiche Beweise für die Unendlichkeit der Primzahlen gefunden, darunter von Christian Goldbach, Leonhard Euler und Paul Erdös. Besonders Eulers Entdeckungen waren ein Wegweiser für die kommende Entwicklung von einer elementaren, in der Tradition der alten Griechen stehenden, hin zu einer modernen Form der Zahlentheorie. Im Jahr 1737, während seiner ersten Zeit in Sankt Petersburg, untersuchte Euler einen neuartigen Zugang zu den Primzahlen und fand heraus, dass sie „verhältnismäßig dicht“ unter den natürlichen Zahlen verstreut sind. Genauer bewies er

Summiert man also nacheinander die Kehrwerte der Primzahlen zusammen, wird auf Dauer jede noch so große obere Schranke durchbrochen. Dies zeigt auf, dass Primzahlen „dichter“ unter den natürlichen Zahlen verstreut sind als die Quadratzahlen,[8] denn Euler zeigte ebenfalls

Quadratzahlen wachsen also langfristig schnell genug an, dass die Summe ihrer Kehrwerte den endlichen Wert 1,645 nicht überschreitet. Euler stand seinerzeit nicht die mathematische Sprache zur Verfügung, diese Verschärfung des Euklidischen Satzes präzise zu interpretieren, und es gibt keinen Nachweis, dass er sich mit exakten Aussagen zur Verteilung von Primzahlen beschäftigte.[9] Allerdings hatte Euler bereits 1737 korrekterweise ohne Beweis behauptet, dass das Verhältnis , wobei die Anzahl der Primzahlen kleiner als bezeichnet, für wachsende gegen 0 strebt.[10]

Eulers Beweisstrategie nutzt das sog. Euler-Produkt. Dabei spielt die eindeutige Zerlegbarkeit natürlicher Zahlen in Primfaktoren eine Schlüsselrolle. Das Euler-Produkt steht in Zusammenhang zu einem Objekt, das bis heute in der Primzahlforschung benutzt wird und in der modernen Mathematik als Riemannsche Zeta-Funktion bekannt ist. Die Zeta-Funktion spielt ebenfalls für die Riemannsche Vermutung eine zentrale Rolle. Die neuartige Leistung bestand darin, Fragen zu Primzahlen systematisch durch funktionale Zusammenhänge zwischen Zahlen zu attackieren. Euler gilt deswegen als Initiator der analytischen Zahlentheorie.[11]

Der Primzahlsatz[Bearbeiten | Quelltext bearbeiten]

Die bloße Unendlichkeit einer Teilmenge der natürlichen Zahlen sagt noch nicht allzu viel über deren Natur aus. Zum Beispiel gibt es unendlich viele gerade Zahlen 2, 4, 6, 8, … und unendlich viele Quadratzahlen 1, 4, 9, 16, …, jedoch weisen beide Folgen bei genauem Hinsehen ein unterschiedliches Verhalten auf. Während zum Beispiel die Differenz zweier aufeinanderfolgender gerader Zahlen stets 2 ist, nehmen die Abstände der Quadratzahlen immer weiter zu, etwa 4 - 1 = 3, 9 - 4 = 5 und 16 - 9 = 7. Beide Folgen haben jedoch ein sehr reguläres Muster gemein, d. h., sie können über einfache Rechenoperationen bestimmt werden. Zum Beispiel ist die n-te gerade Zahl einfach 2n. Im Gegensatz dazu ist bis heute kein einfaches Muster unter der Folge 2, 3, 5, 7, 11, …, 59, 61, 67, … der Primzahlen entdeckt worden. Zum Beispiel gibt es kein „schnelles“ Verfahren, die n-te Primzahl zu berechnen. Es zeigt sich jedoch, dass es auf lange Sicht Muster unter den Primzahlen zu erkennen gibt. Betrachtet man also haufenweise Primzahlen zur gleichen Zeit, so können durch „Mittelwertbildung“ reguläre Strukturen erkannt werden.

Das Prinzip hinter dieser Tatsache ist von statistischer Natur. Statistik bedeutet hierbei, aus einer großen Menge von Daten Muster herauszufiltern, obwohl das „exakte Verhalten“ der einzelnen Datenobjekte (oder Subjekte) sehr kompliziert sein kann. In etwa sind alle Menschen sehr komplex, doch im Verhalten sehr vieler Menschen zur gleichen Zeit können Muster oftmals erkannt werden, die dann in Form von Wahrscheinlichkeiten auf Individuen zurück schließen lassen. Also geht es bei diesen Überlegungen zunächst um die Frage, wie die Verteilung der Primzahlen zu verstehen ist, mit anderen Worten, wie viele Primzahlen unterhalb einer vorgegebenen Schranke zu erwarten sind. Zum Beispiel sind nur 4 Primzahlen, nämlich 2, 3, 5 und 7, kleiner als die Zahl 10. Im Falle der oberen Schranke 150 gibt es schon 35 kleinere Primzahlen, nämlich

- 2, 3, 5, 7, 11, 13, 17, 19, 23, 29, 31, 37, 41, 43, 47, 53, 59, 61, 67, 71, 73, 79, 83, 89, 97, 101, 103, 107, 109, 113, 127, 131, 137, 139, 149.

Dabei sind die insgesamt 20 Primzahlen zwischen 50 und 150 in grün markiert. Eine Frage der Zahlentheorie ist, ob es ein universelles und einfaches Prinzip gibt, zumindest zu schätzen, wie viele Primzahlen es unter einer gegebenen Schranke gibt. Erkannt wurde ein solches erstmals in den Jahren 1792/93 vom damals 15-jährigen Carl Friedrich Gauß,[12] nachdem dieser Logarithmentafeln studiert hatte. Gauß vermutete, dass die Anzahl aller Primzahlen von 2 bis zu einer großen Zahl x ungefähr dem Flächeninhalt zwischen der t-Achse und der Funktion im Intervall von 2 bis entspricht. Dabei ist der natürliche Logarithmus. Es gilt also die Integral-Näherung[13]

- Anzahl der Primzahlen bis

und allgemeiner für :

- Anzahl der Primzahlen zwischen und

Zum Beispiel gilt

womit sich die Formel wegen des exakten Wertes von 20 Primzahlen zwischen 50 und 150 (siehe oben in grün) ca. um den Wert 2 verschätzt. Das Integral von kann nicht elementar geschlossen berechnet werden, da der kehrwertige Logarithmus keine elementare Stammfunktion besitzt. Es definiert somit eine „eigenständige“ Funktion, die auch als Integrallogarithmus bekannt ist:

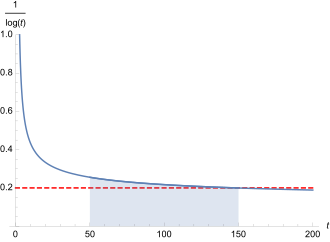

Bezeichnet die Primzahlfunktion, die für beliebige reelle Zahlen definiert ist als die Anzahl der Primzahlen, die nicht größer als sind, so wird die obere Aussage wie folgt präzisiert:

Für wachsende Werte von wird also der obere Quotient immer näher gegen 1 streben, also der relative Fehler der Schätzung gegen 0 gehen. Auch bei der „Statistik der Primzahlen“ gilt demnach der Grundsatz, dass größer werdende Datenmengen prozentual eine zuverlässigere Prognose erlauben. Gauß legte keinen mathematischen Beweis für diese Vermutung über die Primzahlverteilung vor, und es dauerte noch über 100 Jahre, bis ein solcher – unabhängig voneinander von Jacques Hadamard und Charles-Jean de La Vallée Poussin – im Jahr 1896 erbracht wurde.[14] Dabei bedeutet Beweis nicht, dass alle erdenklichen Werte durchprobiert wurden, was bei unendlich vielen Zahlen unmöglich ist, sondern dass ein auf den mathematischen Axiomen basierendes logisches Argument den Sachverhalt in voller Allgemeinheit belegt. Das damit gezeigte Theorem wird als Primzahlsatz bezeichnet.[13]

Wegen (für ) ist der Primzahlsatz deutlich stärker als der Satz des Euklid, da er nicht nur die Unendlichkeit der Menge aller Primzahlen impliziert, sondern auch eine quantitative Idee für deren Verteilung gibt. Im Gegensatz zum Satz des Euklid ist sein Beweis deutlich anspruchsvoller. Klassischerweise wird dieser mit Methoden der komplexen Analysis geführt, wobei Taubersätze ein wichtiges Hilfsmittel sind. Es existieren jedoch auch elementare Beweise, etwa von Paul Erdös und Atle Selberg aus dem Jahr 1949,[15][16] aber auch moderne, wie zum Beispiel von Florian K. Richter aus dem Jahr 2021.[17] Das Wort „elementar“ bezieht sich hierbei primär auf die Methodik und nicht den Schwierigkeitsgrad.[18] Die Riemannsche Vermutung ist wiederum eine weitreichende Verbesserung des Primzahlsatzes.

Varianten der Problemstellung[Bearbeiten | Quelltext bearbeiten]

Die Riemannsche Vermutung stellt eine starke Verschärfung des Primzahlsatzes dar. Das bedeutet, dass sie neben der von Logarithmen stammenden Verteilung der Primzahlen eine sehr exakte quantitative Beschreibung der Abweichungen von der im Primzahlsatz vorhergesagten Integralschätzung postuliert. Sie ordnet das Verhalten der Primzahlen in den Pseudozufall ein. Es existieren einige unterschiedliche und dennoch äquivalente Sichtweisen auf das Problem, die im Folgenden angeführt werden.

Der absolute Fehler im Primzahlsatz[Bearbeiten | Quelltext bearbeiten]

Wie oben bezeichnet die exakte Anzahl von Primzahlen unterhalb der Schranke und den Integrallogarithmus. Der absolute Fehler im Primzahlsatz bezeichnet die Differenz . Dabei gewährleistet der Absolutbetrag, dass nur positive Größen im Ergebnis entstehen, da man sich zunächst nur für die Größe des Fehlers und nicht dessen Vorzeichen interessiert. Der absolute Fehler muss im Gegensatz zum relativen Fehler

keinesfalls gegen 0 gehen. Der Quotient aus und strebt mit wachsendem gegen 1, da Quadrate schneller wachsen als lineare Terme, nicht aber die (sogar unbeschränkte) Differenz beider Terme. Die Riemannsche Vermutung macht eine detaillierte Aussage über den absoluten Fehler im Primzahlsatz.

Vermutung: Der absolute Fehler im Primzahlsatz ist „im Wesentlichen“ von der Ordnung einer Quadratwurzel.[19] Genauer gibt es eine Konstante , sodass für alle Werte die Abschätzung wahr ist, bzw. kürzer für .

Dabei bezeichnet den natürlichen Logarithmus von . Veranschaulicht werden kann diese Aussage wie folgt: Die Quadratwurzel halbiert ungefähr die Anzahl der Ziffern einer Zahl vor dem Komma (wegen in der Hochzahl!). Zum Beispiel hat 100 000 000 insgesamt 9 Ziffern vor dem Komma, aber seine Quadratwurzel 10 000 nur noch 5. Trifft die Riemannsche Vermutung zu, so sollte die Integralschätzung des Primzahlsatzes langfristig ungefähr in der „oberen Hälfte“ der Dezimalziffern vor der Null mit dem tatsächlichen Ergebnis übereinstimmen. Exakt berechnet wurde zum Beispiel , es gibt also ca. 18,4 Trilliarden Primzahlen unterhalb einer Quadrillion.[20][21] Ferner gilt:[19]

Von den insgesamt 23 Stellen vor dem Komma des exakten Wertes gibt es eine Übereinstimmung in den 12 ersten Ziffern mit dem Integrallogarithmus, oben in Blau markiert. Ab der ersten Abweichung sind die Ziffern vor dem Komma rot. Dabei ist 12 in etwa die Hälfte von 23. Diese Berechnung stützt also die Riemannsche Vermutung. Die logarithmischen Terme in der Abschätzung sowie bei sind im Vergleich zur Quadratwurzel so klein, dass dies nichts Wesentliches an dieser ungefähr hälftigen Aufteilung ändert.

Der Mathematiker Lowell Schoenfeld konnte einen passenden Wert für die zunächst unbestimmte Konstante in der Riemannschen Vermutung für hinreichend große Werte genau berechnen: Sollte diese zutreffen, so gilt[22]

- falls

Dabei bezeichnet die Kreiszahl. Ist die Vermutung also wahr, kann in oberer Formulierung im Wesentlichen bereits gesetzt werden.

Obwohl der Term für wachsende Werte immer weiter ansteigt, und damit der absolute Fehler auch beliebig anwachsen kann, besagt die Riemannsche Vermutung, dass dieser relativ betrachtet sehr klein ist, da

fast mit der Geschwindigkeit einer kehrwertigen Quadratwurzel gegen 0 strebt. Wie Jürgen Neukirch bemerkte, weist dies auf eine besondere „Glätte“ in der bildlichen Darstellung der Primzahlverteilung hin, wenn man die Skala hochsetzt.[23]

- Auf kleiner Skala ist die Primzahl zählende Funktion sehr irregulär, und man sieht deutliche Sprünge. Jedes Mal, wenn eine Primzahl erreicht wird, springt die Treppenfunktion um den Wert 1 nach oben.

- Auch bis x = 1000 sind noch Sprünge zu sehen, wenn auch kleiner

- Auf sehr großer Skala wirkt die Kurve der Zählfunktion zunehmend glatt. Die Schwankungen um die absolut glatte Kurve von Li(x) werden relativ betrachtet kleiner, siehe nächstes Bild.

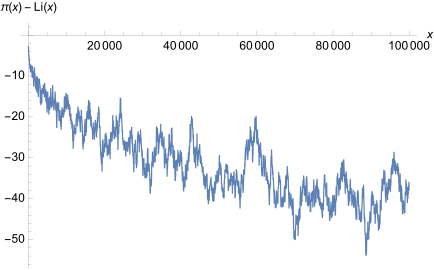

- Im Gegensatz dazu sind die Schwankungen der Funktionendifferenz = Fehler stark ausgeprägt und gut zu sehen. Jedoch ist die Größe im Bereich um die 50 völlig vernachlässigbar, und somit erfasst die Skala des vorigen Bildes diese nicht mehr.

Eine zu verwandte und in der Theorie der Riemannschen Vermutung natürlichere Treppenfunktion wird wie folgt konstruiert. Man startet bei Null, und jedes Mal, wenn eine Primzahlpotenz erreicht wird, springt die Treppenfunktion um den natürlichen Logarithmus der betroffenen Primzahl nach oben. Zum Beispiel ist

- und .

Allgemein gilt die Definition

mit der Mangoldt-Funktion . Die Riemannsche Vermutung kann nun auch wie folgt formuliert werden.

Vermutung: Die Abweichung der Funktion von , Letzteres graphisch der Winkelhalbierenden des 1. Quadranten entsprechend, ist „im Wesentlichen“ von der Ordnung einer Quadratwurzel. Es gibt eine Konstante , sodass für alle , bzw. kürzer für .[24]

Obwohl die Definition der Funktion zunächst komplizierter ist, ist ihre Betrachtung aus mathematischer Sicht natürlicher. Ein Grund dafür ist der verhältnismäßig einfache Zusammenhang zwischen der Mangoldt-Funktion und der sog. Riemannschen Zeta-Funktion, die, auch aus Gründen der Einfachheit und Übersicht, ein essentielles Objekt im Themenkreis der Riemannhypothese ist (siehe unten).[25]

- Schaubild der Funktion im Intervall . Für jede Primzahlpotenz, wie 2, 8 oder 9, gibt es einen Sprung. Die Sprünge haben je nach Primzahlpotenz unterschiedliche Höhe .

- Schaubild der Funktion im Intervall zusammen mit der Ursprungsgeraden mit Steigung 1

- Auf höherer Skala, wie etwa , wird die Ähnlichkeit zur Winkelhalbierenden immer deutlicher

Wahrscheinlichkeitstheoretische Interpretation[Bearbeiten | Quelltext bearbeiten]

Die Riemannsche Vermutung kann probabilistisch interpretiert werden. Dies geht auf den Mathematiker Arnaud Denjoy zurück.[26]

Der zentrale Grenzwertsatz[Bearbeiten | Quelltext bearbeiten]

Um den Zusammenhang zwischen den Primzahlen auf der einen Seite und der Wahrscheinlichkeitstheorie auf der anderen Seite zu verstehen, wird der zentrale Grenzwertsatz benötigt. Der einfachste Vergleich beider Konzepte entsteht über die Betrachtung eines fairen Münzwurfes. Es wird eine faire Münze mit den möglichen Ergebnissen „Kopf“ und „Zahl“ mehrmals hintereinander geworfen. In der idealen Situation ist das Ergebnis jeden Wurfs an sich absolut zufällig und außerdem hängen die Ergebnisse der Würfe nicht voneinander ab. Wurde also zunächst Kopf geworfen, soll dies unerheblich dafür sein, ob wieder Kopf oder auch Zahl folgt. Die in dieser Situation falsche Annahme, nach einer langen Strecke von „Kopf“-Würfen seien „Zahl“-Würfe wahrscheinlicher, ist indes als Spielerfehlschluss bekannt („der Zufall hat kein Gedächtnis“).

Unter Annahme absoluten Zufalls bei gleichen Wahrscheinlichkeiten und außerdem Unabhängigkeit der einzelnen Würfe kann bei häufigem Wiederholen eines Münzwurfes ein bestimmtes Muster beobachtet werden. Am besten wird dies veranschaulicht, wenn die Ereignisse „Kopf“ und „Zahl“ durch die Zahlen bzw. ersetzt werden und nach jeder Serie von Würfen die Summe aller Wurfergebnisse gebildet wird. Dies entspricht dann der Bilanz in einem Glücksspiel, in dem bei Kopf 1 Euro gewonnen und bei Zahl 1 Euro verloren wird. Werden „Kopf“ – „Kopf“ – „Zahl“ – „Zahl“ – „Kopf“ geworfen, liegt der Gewinn bei 1 Euro, denn

Gleichzeitig entspricht dies der Differenz aus geworfenen „Köpfen“ und „Zahlen“. Bei einer sehr großen Anzahl an Würfen, etwa 40 000, ist die Annahme naheliegend, dass jeweils ungefähr 20 000 Mal „Kopf“ und „Zahl“ geworfen wird, da beide Ergebnisse exakt gleiche Wahrscheinlichkeit haben. Dies hätte als mögliche Konsequenz, dass sich die Gewinnbilanz in etwa beim Wert Null „einpendelt“, da angenommen wurde, dass der Wert in etwa so häufig summiert wurde wie . Auf der anderen Seite ist es bereits in diesen Größenordnungen extrem unwahrscheinlich, dass etwa ein Ergebnis wie genau 20 000-mal Kopf und genau 20 000-mal Zahl auftritt, was einer Gewinnbilanz von exakt 0 entspräche. Es ist eher damit zu rechnen, dass der Zufall zu „Gunsten“ von „Kopf“ oder „Zahl“ einen gewissen „Ausreißer“ verursachen wird. Das bedeutet, dass nach der Wurfserie sehr wahrscheinlich eine gewisse Größe häufiger gefallen sein wird als die andere, obwohl zu Beginn gleiche Wahrscheinlichkeiten vorlagen. Die Größe dieses „Ausreißers“ ist Gegenstand des zentralen Grenzwertsatzes: Bezeichnet die Zufallsgröße mit dem Wert des -ten Wurfes, so errechnet sich der Gewinn des oberen Spiels mit Münzwürfen durch

Beginnt der Spieler mit 0 Euro auf dem Konto, kann auch als Kontostand nach Würfen interpretiert werden. Der zentrale Grenzwertsatz trifft eine Aussage über das zu erwartende Verhalten des Gewinns , wenn beliebig groß wird. Ihm zufolge liegt die Größenordnung von stets im Umfeld der Quadratwurzel der Wurfanzahl ; genauer gilt für die Wahrscheinlichkeit, dass , die Näherung[27][Anm. 2]

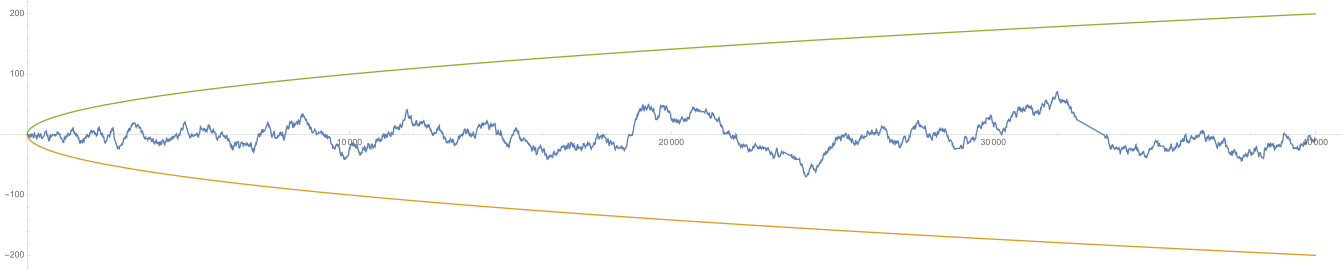

Dem Integral liegt die Verteilungsfunktion der Standardnormalverteilung zugrunde. Wird zum Beispiel eine Münze 40 000 Male hintereinander geworfen, so ist die Wahrscheinlichkeit, dass der Kontostand am Ende im Bereich liegt wegen ungefähr 68,2 % (siehe Bild rechts, die Abweichung ist hier ). Negative Zahlen auf dem Konto werden als Schulden verstanden.

- Eine mögliche Entwicklung des Kontostands im Laufe eines Spiels mit 40 000 Münzwürfen entspricht mathematisch einer Irrfahrt. Zur Größenorientierung sind die Funktionen in grün bzw. orange mit eingetragen. Kurz vor Ende des Spiels beobachtet man eine „Pechsträhne“. Extreme Ereignisse, wie ein steiler Anstieg bis 40 000 (nur „Kopf“), sind zwar nicht unmöglich, aber sehr unwahrscheinlich und entsprechen nicht einem „typischen Verlauf“ des besagten Spiels.

Der zentrale Grenzwertsatz findet anschaulich den „Mittelweg“ zwischen zwei extremen und jeweils äußerst unwahrscheinlichen Ereignissen: einmal, dass (fast) genau so häufig „Kopf“ wie „Zahl“ geworfen wird, oder zweitens, dass „sehr viel“ häufiger „Kopf“ als „Zahl“ geworfen wird oder umgekehrt. Es stünde ein zu reguläres Verteilungsmuster mit der geforderten Unabhängigkeit der Würfe in Konflikt, und ein zu starkes Abweichen vom Mittelwert 0 mit der ebenfalls geforderten gleichen Wahrscheinlichkeit. Die Bestimmung der genauen Größenordnung ist kein einfaches Unterfangen, und Gegenstand des Beweises des zentralen Grenzwertsatzes, der mit Methoden der höheren Analysis geführt wird.[28]

Wegen der über die Normalverteilung gegebenen Wahrscheinlichkeiten gilt insbesondere für jede Zahl :

- mit Wahrscheinlichkeit 100 % (in einem asymptotischen Sinn).

Dabei ist die Potenzschreibweise zu beachten.

Primzahlen und Pseudozufall[Bearbeiten | Quelltext bearbeiten]

Eine „Verbindung“ zwischen Primzahlen und dem wiederholten Münzwurf kann im Sinne des zentralen Grenzwertsatzes wie folgt hergestellt werden.[29] Es werden nacheinander die natürlichen Zahlen betrachtet; und zwar in deren eindeutiger Primfaktorzerlegung. Jedes Mal, wenn die Anzahl der Faktoren gerade ist, wird dies als gewertet, und wenn sie ungerade ist, als . Über dieses Prozedere lässt sich eine Funktion auf den natürlichen Zahlen definieren:

- , wobei Anzahl der Primfaktoren von .

Diese wird auch als Liouville-Funktion bezeichnet, benannt nach Joseph Liouville.[30] Zu beachten ist, dass ein Produkt mit einer ungeraden Anzahl aus lauter Faktoren −1 wieder −1 ist, und eines mit einer geraden Anzahl an Faktoren −1 genau +1, da Minus mal Minus Plus ergibt. Zum Beispiel hat die Zahl insgesamt fünf Primfaktoren, denn

und daher gilt . Die folgende Tabelle zeigt den Sachverhalt für einige weitere Werte von .

| n | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 | … | 236 | 237 | 238 | 239 | … | 174.635.999 | 174.636.000 | 174.636.001 | 174.636.002 | … |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Primfaktorzerlegung | – | 2 | 3 | 22 | 5 | 2·3 | 7 | 23 | 32 | 2·5 | 11 | 22·3 | … | 22·47 | 3·79 | 2·7·17 | 239 | … | 29·379·15.889 | 25·34·53·72·11 | 174.636.001 | 2·17·71·73·991 | … |

| Faktoranzahl Ω(n) | 0 | 1 | 1 | 2 | 1 | 2 | 1 | 3 | 2 | 2 | 1 | 3 | … | 3 | 2 | 3 | 1 | … | 3 | 15 | 1 | 5 | … |

| λ(n) = (–1)Ω(n) | 1 | −1 | −1 | 1 | −1 | 1 | −1 | −1 | 1 | 1 | −1 | −1 | … | −1 | 1 | −1 | −1 | … | −1 | −1 | −1 | −1 | … |

Das genaue Verhalten der Primfaktorzerlegungen ist, für größer werdende Zahlen, ohne eine sehr aufwändige Berechnung nicht vorherzusagen und unterliegt starken Schwankungen. Die Riemannsche Vermutung besagt, dass die von der Liouville-Funktion definierte Folge pseudozufällig ist.[31][30] Sie ist zwar determiniert, kann also theoretisch berechnet werden und ihre Werte „liegen alle bereits fest“, dennoch ähnelt sie in ihren Eigenschaften einem sogenannten Random Walk.[32] Damit, so die Vermutung, sollten sich die aufaddierten Werte der Liouville-Funktion auf lange Sicht ungefähr wie ein „typischer Verlauf“ des oben beschriebenen Glücksspiels mit einem fairen Münzwurf verhalten.[30] Es kann für

festgehalten werden:

Vermutung: Es gilt, im Sinne des zentralen Grenzwertsatzes, für jedes beliebige . Äquivalent ist die Aussage, dass es für alle eine Konstante gibt, sodass die Ungleichung für alle gilt, kurz .[33]

Diese Form der Pseudozufälligkeit sagt anschaulich aus, dass sich Primzahlen in ihren Eigenschaften, wie Verteilung und Primfaktorzerlegung, „möglichst zufällig“ und „möglichst unabhängig“ verhalten. So soll zum Beispiel die Frage, ob sich eine zufällig gewählte Zahl in eine gerade oder in eine ungerade Anzahl an Primfaktoren zerlegen lässt, für wachsende Größe von mit „gleicher Wahrscheinlichkeit“ beantworten lassen.[30] Gleichzeitig sollen die Werte und für wachsende Werte „unabhängig“ sein. Also soll es keine einfache Möglichkeit geben, aus dem Verhalten des einen Wertes, das Verhalten des anderen zu ermitteln. Betrachtet man zum Beispiel

und den Nachfolger

- ,

so ist nicht unmittelbar ersichtlich, wie die Anzahlen der Primfaktoren kausal zusammenhängen.

- Die Funktion bis x = 40 000 zusammen mit (orange). Etwa zwischen 18 000 und 20 000 gibt es ein gehäuftes Auftreten von Zahlen mit einer geraden Anzahl an Primfaktoren, das sich aber mit den üblichen Schwankungen eines Zufallsprozesses rechtfertigen lässt.

Wäre die Riemannsche Vermutung falsch, so gäbe es ein Ungleichgewicht in der Primzahlverteilung in dem Sinne, dass es zum Beispiel streckenweise unnatürlich viel gehäufter Zahlen mit einer geraden Anzahl an Primfaktoren, wie 10, 14, 25, 132, gäbe, als Zahlen mit einer ungeraden Anzahl an Primfaktoren, wie 7, 8, 12, 18 und 125. Das Scheitern der Riemannschen Hypothese würde die Verteilung der Primzahlen durcheinander bringen.[34]

Analog kann die Riemannhypothese auch für die Möbius-Funktion formuliert werden. Diese nimmt für Zahlen, die in eine ungerade bzw. gerade Anzahl paarweise verschiedener Primzahlen zerfallen, den Wert bzw. an, und wird für Zahlen, die mehrfach durch denselben Primteiler teilbar ist, . Es ist also zum Beispiel , und , da im letzten Fall die 3 mehr als einmal auftauchte.

Die Riemannsche Vermutung trifft genau dann zu, wenn für alle die Beschränkung für erfüllt ist.

Auch hier wird also eine Form der Pseudozufälligkeit vermutet.

Der Begriff der „Zufälligkeit“ unter den Primzahlen ist bis heute in erster Linie auch in Fachkreisen eine Anschauung, und bisher weder vollständig verstanden noch rigoros beschrieben worden. Heuristisch lassen sich einige wichtige Probleme, wie die Bestätigung der Goldbachschen Vermutung, aus dieser Eigenschaft herleiten, jedoch führt die gleiche Heuristik in anderen Fällen zu Widersprüchen.[35][36]

Der Weg über unendliche Reihen[Bearbeiten | Quelltext bearbeiten]

Um Fragen zu Primzahlen mit Mitteln der Analysis angreifen zu können, sind unendliche Reihen ein erstes Werkzeug.

Allgemeines zu Reihen[Bearbeiten | Quelltext bearbeiten]

Unter einer Reihe versteht man, veranschaulicht, eine niemals endende Summe von Zahlen. Dies können reelle, aber auch komplexe Zahlen sein. Die Dezimalschreibweise einer reellen Zahl kann als Reihe aufgefasst werden, etwa

oder auch

mit der Kreiszahl . Die durch die Punkte angedeuteten Summen enden niemals, da die Dezimalentwicklung von periodisch und die Kreiszahl irrational ist. Es gibt Reihen, die nicht geschlossen als Zahl darstellbar sind, etwa

aber auch solche, die gegen einen Grenzwert konvergieren (wie die oberen Beispiele mit Grenzwerten bzw. ). Reihen wie , die nicht konvergieren, nennt man divergent. Veranschaulichend gesagt kann eine Reihe nur dann konvergieren, falls die Glieder „schnell genug gegen 0 streben“. Aber nicht jede Reihe, deren Glieder gegen 0 streben, konvergiert, wie man an der harmonischen Reihe

sieht.

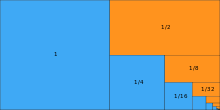

Einige Reihen spielen eine ganz besondere Rolle in der Mathematik, zum Beispiel die geometrische Reihe, die aufgrund der Euler-Produkte auch im Kontext der Riemannhypothese bedeutsam ist: Das Prinzip ist, zu einer Zahl alle natürlichen Potenzen aufzuaddieren. Man erhält dann

Es ist also zu jedem mit möglich, den Grenzwert der geometrischen Reihe geschlossen anzugeben. Es handelt sich auch um ein erstes Beispiel, dass eine Funktion durch eine Reihe definiert ist: man hat

und die Reihenglieder hängen sämtlich von ab. Die geometrische Reihe ist damit das Beispiel und , wobei für den ersten Summanden die Regel (und formal ) zu beachten ist.

Der Majorantentest und partielle Summation[Bearbeiten | Quelltext bearbeiten]

Die Bestimmung des Grenzwertes einer Reihe ist im Allgemeinen nicht einfach, doch in manchen Fällen ist bereits die Frage der Konvergenz schwer zu beantworten. In der Geschichte der Mathematik wurden Kriterien entwickelt, zu entscheiden, ob gewisse Reihen konvergieren oder nicht. Eines davon ist der Majorantentest: Dieser basiert auf der einfachen Überlegung, dass eine unendliche Summe nicht-negativer Zahlen, die nach oben beschränkt ist, bereits konvergieren muss. Ist also eine Zahlenfolge und für alle , so gilt:

- konvergiert konvergiert.

Anschaulich gehen die Werte für Konvergenz schnell genug gegen 0, weshalb es wegen auch die Werte tun müssen. Eine wichtige Folgerung dieses Prinzips ist, dass aus der Konvergenz der Reihe über die Absolutbeträge notwendigerweise schon die Konvergenz der Reihe folgt. Eine besonders wichtige Majorante ist die Reihe

die für reelle Zahlen konvergiert, was mit dem Integralkriterium gesehen werden kann. Sie kann dazu dienen, die Konvergenz sog. Dirichlet-Reihen nachzuweisen.

Eine andere Technik betrifft den Umgang mit Reihen der Form

Dabei werden die Folgen und „separiert“:

- wobei , sofern .

Dieser Umordnungstrick geht auf den Mathematiker Niels Henrik Abel zurück und wird als partielle Summation bezeichnet. Rückwirkend bestätigen lässt sich dies durch sukzessives Ausmultiplizieren und Verrechnen der Terme. Dieser Trick kommt vor allem dann zum Einsatz, wenn die Zahlen „schwanken“ (etwa ständige Vorzeichenwechsel), womit deren Summen verhältnismäßig klein sind, während die Zahlen sukzessive kleiner werden, da dann die Differenzen eventuell viel schneller gegen Null streben als die selbst. Die notwendige Bedingung besagt ihrerseits, dass das Abklingen der gegen Null das Wachstum des Terms dominiert.

Zusammenfassend lässt sich, sofern die Nebenbedingung erfüllt ist, mit und folgende Variante des Majorantentests anführen:[37]

- konvergiert konvergiert konvergiert.

Die Riemannsche Vermutung und Reihenkonvergenz[Bearbeiten | Quelltext bearbeiten]

Im Rahmen der Riemannhypothese ist die Reihe

von Interesse, wobei die Liouville-Funktion bezeichnet. Diese ist jedoch nicht konvergent, da die nicht gegen Null streben. Allerdings kann man den Summanden weitere Terme hinzufügen, die dann Konvergenz erzwingen. Hängen die hinzugefügten Terme noch von einer Variablen ab, kann aus der zu untersuchenden Folge eine Funktion erzeugt werden. Etwa ist auch

nicht konvergent, doch betrachtet man die zugehörige Potenzreihe, ergibt sich für die Funktion

- .

Wie die Primzahlen selbst schöpft die Liouville-Funktion Struktur aus Gesetzen multiplikativer Art. Es gilt das Gesetz , sie ist also eine streng multiplikative Funktion. Diese Eigenschaft bietet mathematisch viele Vorteile und muss daher für die weitere Analyse erhalten bleiben. Statt also Terme mit konstanter Basis und veränderlichem Exponenten hinzuzufügen, werden Ausdrücke mit veränderlicher Basis und konstantem Exponenten in Betracht gezogen. Mit den Potenzgesetzen folgt damit

und die Multiplikativität bleibt beim Übergang erhalten. Historisch bedingt werden die Exponenten mit statt bezeichnet und man nennt den resultierenden Reihentyp auch Dirichlet-Reihe. Dirichlet-Reihen können mit partieller Summation gut analysiert werden: Es sind Potenzfunktionen in , und durch Nehmen der Differenzen werden diese um den Faktor kleiner:

- (zum Beispiel wird aus eine lineare Funktion, und dieses Prinzip überträgt sich von auf beliebige Exponenten).

Dabei bedeutet das Zeichen , dass die linke Seite bis auf einen von abhängigen aber von unabhängigen Faktor stets kleiner ist als die rechte Seite. Der zusätzliche Faktor macht den Term um eine Potenzgrößenordnung kleiner als . Setzt man weiter mit der Liouville-Funktion, so haben diese Vorzeichenwechsel. Die Häufigkeit des Wegkürzens der Terme innerhalb steht mit der Anzahl der Zahlen mit gerader bzw. ungerader Primfaktoranzahl unterhalb in direktem Zusammenhang, und die Riemannsche Vermutung (RV) besagt für alle (siehe oben). Setzt man diese voraus, gilt für alle die Nebenbedingung und es folgt für eben diese mit Majorantentest und partieller Summation:

- konvergiert.

Im letzten Schritt kann so klein gewählt werden, dass wird, etwa durch . Die gleichen Überlegungen gelten für die Möbius-Funktion. Daraus motiviert sich:

Vermutung: Die Reihen bzw. konvergieren für alle .

Mit folgert man für mit dem Majorantentest

weshalb die betroffene Reihe hier „trivialerweise“ konvergiert. Gleiches gilt für die Möbius-Funktion. Dieses einfache Verfahren ist für nicht mehr möglich. Bereits der Fall ist schwierig und fruchtet durch eine zahlentheoretische Folgerung: Aus der Konvergenz der Reihe

gegen den Grenzwert 0 kann der Primzahlsatz gefolgert werden. Dass der Grenzwert tatsächlich 0 ist, fällt als „Beigabe“ beim Beweis der Konvergenz mit heraus.[38] Über die Fälle ist bis heute nichts bekannt. In diesem Sinne ist die Riemannsche Vermutung auch in dieser Hinsicht eine deutliche Verschärfung des Primzahlsatzes.

Formulierung über die Holomorphie von Dirichlet-Reihen[Bearbeiten | Quelltext bearbeiten]

In ihrer ursprünglichen Fassung ist die Riemannsche Vermutung zunächst kein Problem der Zahlentheorie, sondern ein Problem der komplexen Analysis. Die komplexe Analysis beschäftigt sich mit den Eigenschaften holomorpher Funktionen, sowie sich die klassische (reelle) Analysis mit den Eigenschaften differenzierbarer Funktionen beschäftigt.

Die Riemannhypothese besagt unter anderem, dass die Dirichlet-Reihe der Liouville-Funktion

eine in einem „möglichst großen Bereich“ holomorphe Funktion darstellt. Dabei ist „großer Bereich“ näher zu spezifizieren. Ähnlich wie die Konvergenzfrage im Reellen misst die Holomorphie das Verhalten der Reihe , und ein großer Holomorphiebereich impliziert ein „starkes“ gegenseitiges Wegheben der Terme in dieser Reihe.

Um Dirichlet-Reihen als holomorphe Funktionen zu sehen, müssen diese auch an komplexen Zahlen ausgewertet werden. Unter Verwendung der Formel von Euler, die imaginäre Zahlen im Exponenten sinnvoll interpretiert, gelingt dies für wie folgt:

Die Vorschrift im Komplexen für eine Dirichlet-Reihe lautet also

Wegen der Beschränktheit von Sinus und Kosinus für reelle Zahlen sieht man damit, dass sich das Verhalten von für festen Realteil aber veränderlichen Imaginärteil im Exponenten nur „geringfügig ändert“. Der Realteil von bestimmt die absolute Größe des Terms , während der Imaginärteil nur eine „Schwingung“ erzeugt, die in der komplexen Ebene als Drehung entlang des Einheitskreises verstanden werden kann. Genau genommen gilt . Bei wachsendem Realteil von nähern sich die Terme zunehmend der Null, weshalb die Konvergenzbedingungen „immer besser werden“. Unter anderem mit dieser Beobachtung kann eine bedeutende Eigenschaft für Funktionen gezeigt werden, die durch eine Dirichlet-Reihe definiert sind: Konvergiert eine Dirichlet-Reihe an einer Stelle , so tut sie das bereits an jeder Stelle mit , wobei an den Imaginärteil keine besonderen Bedingungen gestellt sind. Im Innern ihres Konvergenzbereichs stellt sie eine holomorphe Funktion dar.

Es folgt damit, dass Dirichlet-Reihen auf offenen Halbebenen der komplexen Ebene konvergieren und dort holomorph sind. Konvergiert eine Dirichlet-Reihe irgendwo, so gibt es ferner eine eindeutig bestimmte Zahl , die sogenannte Konvergenzabszisse, so dass die Dirichlet-Reihe für alle komplexen Zahlen mit konvergiert, und für alle mit divergiert. Über die Fälle kann keine allgemeine Aussage getroffen werden. Hiermit ergibt sich eine weitere Formulierung der Riemannhypothese. Ist die Reihe für alle konvergent, so auch für alle mit , und umgekehrt.

Vermutung: Die Reihen und konvergieren für alle mit , und insbesondere ist die von der Liouville- bzw. Möbius-Funktion erzeugte Dirichlet-Reihe in der Halbebene holomorph.

Für den Primzahlsatz wird lediglich die holomorphe Fortsetzbarkeit in den Bereich benötigt.[39] Über diese erste funktionentheoretische Fassung ist es möglich, den Zusammenhang zwischen der Primzahlverteilung und Nullstellen der sogenannten Riemannschen Zeta-Funktion zu formulieren.

Primzahlen und die Nullstellen der Zeta-Funktion[Bearbeiten | Quelltext bearbeiten]

Wie Bernhard Riemann bereits 1859 erkannte, besteht eine enge Verbindung zwischen Primzahlen und den Nullstellen einer bestimmten Funktion. Diese trägt den Namen Riemannsche Zeta-Funktion, und wird mit dem griechischen Buchstaben Zeta (klein) notiert; also . Es ist die Variablenbenennung im Kontext der Zeta-Funktion jedoch unüblich, da sie nicht nur reelle Zahlen entgegennimmt und abbildet, sondern auch komplexe Zahlen. Als Variable hat sich im Laufe der Zeit die von Riemann gewählte Benennung durchgesetzt, wobei (Sigma) der Realteil und der Imaginärteil von ist. Das Symbol bezeichnet wie üblich die imaginäre Einheit und erfüllt . Eine (komplexe) Nullstelle der Zeta-Funktion erfüllt die Gleichung .

Die Riemannsche Zeta-Funktion[Bearbeiten | Quelltext bearbeiten]

Die Riemannsche Zeta-Funktion wird in der Literatur als diejenige Dirichlet-Reihe definiert, deren Koeffizienten ausschließlich 1 sind, mit anderen Worten

Mit dem Majorantentest sieht man, dass die Reihe für alle Werte mit konvergiert. An der Stelle erhält man gerade die harmonische Reihe:

also gilt , damit ist die Konvergenzabszisse von , und die Dirichlet-Reihe wird die Zeta-Funktion nicht mehr für Zahlen

French

French Deutsch

Deutsch