عدالت (یادگیری ماشین) - ویکیپدیا، دانشنامهٔ آزاد

عدالت در یادگیری ماشین به تلاشهای مختلف برای تصحیح algorithmic bias (تعصب الگوریتمی) در فرآیندهای تصمیمگیری خودکار بر اساس مدلهای یادگیری ماشین اشاره دارد. همانطور که در مورد بسیاری از مفاهیم اخلاقی وجود دارد، تعاریف عدالت و تعصب همیشه بحثبرانگیز است. بهطور کلی، عدالت و تعصب وقتی مرتبط تلقی میشود که فرایند تصمیمگیری بر زندگی افراد تأثیر میگذارد، به ویژه با توجه به مجموعه ای از متغیرهای حساس مانند جنسیت، قومیت، گرایش جنسی، ناتوانی و غیره. در یادگیری ماشین، مسئله algorithmic bias (تعصب الگوریتمی) به خوبی شناخته شده و به خوبی مطالعه شدهاست. نتایج ممکن است توسط طیفی از عوامل منحرف شود و بنابراین ممکن است با توجه به گروهها یا افراد خاص ناعادلانه در نظر گرفته شود. یک مثال میتواند راهی باشد که سایتهای رسانههای اجتماعی اخبار شخصیسازی شده را به مصرفکنندگان ارائه میکنند.

متن

[ویرایش]تحقیق در مورد عدالت در یادگیری ماشینی موضوع نسبتاً جدیدی است. در سال ۲۰۱۸، اکثر مقالات در این زمینه در سه سال گذشته منتشر شده بودند.[۱] در همان سال، AI Fairness 360 ،IBM را معرفی کرد، یک کتابخانه پایتون با چندین الگوریتم برای کاهش تعصب نرمافزار و افزایش عدالت آن[۲][۳] و فیسبوک استفاده خود را از ابزاری به نام جریان عدالت برای تشخیص تعصب در هوش مصنوعی خود عمومی کرد. اگر چه، کد منبع ابزار در دسترس نیست.[۴] در سال ۲۰۱۹، گوگل مجموعه ای از ابزارها را در گیتهاب منتشر کرد تا اثرات عدالت را در بلندمدت بررسی کند.[۵]

اختلافات

[ویرایش]استفاده از تصمیمگیری الگوریتمی در نظام حقوقی یک حوزه قابل توجه مورد استفاده تحت بررسی بودهاست. در سال ۲۰۱۴، اریک هولدر، دادستان کل ایالات متحده، این نگرانی را مطرح کرد که روشهای «ارزیابی ریسک» ممکن است بر عواملی که تحت کنترل متهم نیستند، مانند سطح تحصیلات یا پیشینه اقتصادی-اجتماعی آنها تمرکز نادرست داشته باشد.[۶] یک گزارش تحقیقی که توسط پروپابلیکا در سال ۲۰۱۶ منتشر شد، ادعا کرد که نرمافزار COMPAS، که بهطور گسترده در دادگاههای ایالات متحده برای پیشبینی recidivism (تکرار جرم) استفاده میشود، تعصب نژادی است. این گزارش ادعا کرد که متهمان سیاهپوست تقریباً دو برابر بیشتر از متهمان سفیدپوست بهطور نادرست به عنوان خطر بالاتر برچسبگذاری میشوند، در حالی که با متهمان سفیدپوست اشتباه معکوس را مرتکب میشوند.[۷] تعصب نژادی و جنسیتی نیز در الگوریتمهای تشخیص تصویر مورد توجه قرار گرفتهاست. مشخص شدهاست که تشخیص چهره و حرکت در دوربینها، حالات صورت سوژههای غیرسفید را نادیده میگیرد یا اشتباه میگذارد.[۸] در سال ۲۰۱۵، ویژگی برچسبگذاری خودکار در فلیکر و گوگل فوتوز برای برچسبگذاری سیاهپوستان با برچسبهایی مانند «حیوان» و «گوریل» پیدا شد.[۹] یک مسابقه بینالمللی زیبایی در سال ۲۰۱۶ که توسط یک الگوریتم هوش مصنوعی داوری شد، مشخص شد که نسبت به افرادی با پوست روشنتر، احتمالاً به دلیل تعصب در دادههای آموزشی، تعصب دارد.[۱۰] مطالعهای روی سه الگوریتم طبقهبندی جنسیتی تجاری در سال ۲۰۱۸ نشان داد که هر سه الگوریتم معمولاً در طبقهبندی مردان با پوست روشن دقیقترین و بدترین در طبقهبندی زنان با پوست تیره هستند.

شاخص گروه عدالت

[ویرایش]در مسائل طبقهبندی، یک الگوریتم تابعی را برای پیشبینی یک مشخصه گسسته میآموزد، متغیر هدف، از ویژگیهای شناخته شده است. به عنوان یک متغیر تصادفی گسسته مدل میکنیم که برخی از ویژگیهای موجود یا بهطور ضمنی رمزگذاری شده در که به عنوان ویژگیهای حساس (جنسیت، قومیت، گرایش جنسی و غیره) در نظر میگیریم). پیشبینی طبقهبندی کننده را در نهایت با نشان میدهیم حال اجازه دهید سه معیار اصلی را برای ارزیابی عادل بودن یک طبقهبندیکننده را مشخص کنیم، یعنی اگر پیشبینیهای آن تحت تأثیر برخی از این متغیرهای حساس قرار نگیرد.[۱۱]

استقلال (آزادی)

[ویرایش]را اقناع استقلال متغیرهای تصادفی میگوییم اگر ویژگیهای حساس مشخصه از نظر متغیر تصادفی مستقل از پیشبینی هستند، و ما مینویسیمهمچنین میتوانیم این مفهوم را با فرمول زیر بیان کنیم:این بدان معنی است که نرخ طبقهبندی برای هر کلاس هدف برای افراد متعلق به گروههای مختلف با توجه به ویژگیهای حساس برابر مشخصه است.

با این حال میتوان یک عبارت معادل دیگر برای استقلال با استفاده از مفهوم اطلاعات متقابل بین متغیرهای تصادفی ارائه داد که به این صورت تعریف شدهاست.در این فرمول، آنتروپی متغیر تصادفی است. سپس اقناع استقلال است اگر باشد.

یک آرامش احتمالی در تعریف استقلال شامل معرفی یک سستی مثبت است و با این فرمول به دست میآید:در نهایت، یکی دیگر از آرامشهای احتمالی نیاز است باشد.

جدایی

[ویرایش]را متغیرهای تصادفی اقناع جدایی میگوییم اگر ویژگیهای حساس است از نظر آماری مستقل از پیشبینی هستند با توجه به مقدار هدف ، و ما مینویسیمهمچنین میتوانیم این مفهوم را با فرمول زیر بیان کنیم:این بدان معنی است که تمام وابستگی تصمیم روی ویژگی حساس باید با وابستگی واقعی متغیر هدف واقعی توجیه شود.

عبارت معادل دیگر، در مورد نرخ هدف باینری، این است که نرخ مثبت واقعی و نرخ مثبت کاذب برابر هستند (و بنابراین نرخ منفی کاذب و نرخ منفی واقعی برابر هستند) برای هر مقدار از ویژگیهای حساس:یک تخفیف ممکن برای تعاریف داده شده این است که اجازه دهیم مقدار اختلاف بین نرخها عددی مثبت کمتر از یک سستی باشد. ، به جای برابر با صفر.

{{سخ}}در برخی زمینهها، جداسازی (ضریب جداسازی) در یک ماتریس درهم ریختگی، اندازهگیری فاصله (در سطح معینی از امتیاز احتمال) بین درصد تجمعی پیشبینیشده منفی و درصد تجمعی پیشبینیشده مثبت است.

هر چه این ضریب تفکیک در یک مقدار امتیاز معین بیشتر باشد، مدل در تمایز بین مجموعه مثبت و منفی در یک برش احتمال خاص مؤثرتر است. به گفته مایز: «اغلب در صنعت اعتبار مشاهده میشود که انتخاب معیارهای اعتبارسنجی به رویکرد مدلسازی بستگی دارد. به عنوان مثال، اگر روش مدلسازی پارامتری یا نیمه پارامتری باشد، اغلب از آزمون کولموگروف–اسمیرنف دو نمونه استفاده میشود. اگر مدل با روشهای جستجوی اکتشافی یا تکراری مشتق شده باشد، معیار عملکرد مدل معمولاً <b id="mwkg">واگرایی</b> است. گزینه سوم ضریب تفکیک است. . . ضریب جداسازی، در مقایسه با دو روش دیگر، برای عملکرد مدل بهعنوان معیاری معقولتر به نظر میرسد، زیرا الگوی جداسازی یک مدل را منعکس میکند.

کفایت

[ویرایش]را متغیرهای تصادفی اقناع کفایت میگوییم اگر ویژگیهای حساس است از نظر آماری مستقل از مقدار هدف هستند با توجه به پیشبینی ، و ما مینویسیمهمچنین میتوانیم این مفهوم را با فرمول زیر بیان کنیم:این بدان معنی است که احتمال حضور واقعی در هر یک از گروهها برای دو فرد با ویژگیهای حساس متفاوت برابر است، با توجه به اینکه پیشبینی شده بود که آنها به یک گروه تعلق دارند.

روابط بین تعاریف

[ویرایش]در نهایت، برخی از نتایج اصلی را که به سه تعریف ارائه شده در بالا مربوط میشود، خلاصه میکنیم:

- با فرض اینکه باینری است، اگر و از نظر آماری مستقل نیستند و و از نظر آماری نیز مستقل نیستند، پس استقلال و جدایی هر دو نمیتوانند برقرار باشند.

- اگر به عنوان یک توزیع مشترک دارای احتمال مثبت برای تمام مقادیر ممکن است و و از نظر آماری مستقل نیستند، پس جدایی و کفایت هر دو نمیتوانند برقرار باشند.

فرمول بندی ریاضی تعاریف عدالت گروهی

[ویرایش]تعاریف اولیه

[ویرایش]بیشتر معیارهای آماری عدالت بر معیارهای مختلفی تکیه دارند، بنابراین ما با تعریف آنها شروع میکنیم. هنگام با یک طبقهبندی باینری کار میکند، هم کلاسهای پیشبینیشده و هم کلاسهای واقعی میتوانند دو مقدار داشته باشند: مثبت و منفی. اکنون اجازه دهید شروع به توضیح روابط ممکن مختلف بین نتیجه پیشبینیشده و واقعی کنیم:[۱۲]

- مثبت واقعی (TP): موردی که هم نتیجه پیشبینیشده و هم نتیجه واقعی در یک کلاس مثبت هستند.

- منفی واقعی (TN): موردی که هم نتیجه پیشبینیشده و هم نتیجه واقعی به کلاس منفی نسبت داده میشوند.

- مثبت کاذب (FP): موردی که پیشبینی میشود در یک کلاس مثبت که در نتیجه واقعی تخصیص داده میشود، به طبقه منفی میرسد.

- منفی کاذب (FN): موردی که پیشبینی میشود در کلاس منفی با نتیجه واقعی باشد، در حالت مثبت است.

این روابط را میتوان به راحتی با یک ماتریس درهمریختگی نشان داد، جدولی که دقت یک مدل طبقهبندی را توصیف میکند. در این ماتریس، ستونها و ردیفها به ترتیب نمونههایی از موارد پیشبینی شده و واقعی را نشان میدهند.

با استفاده از این روابط، میتوانیم معیارهای متعددی را تعریف کنیم که بعداً میتوان برای اندازهگیری عادلانه بودن یک الگوریتم استفاده کرد:

- مقدار پیشبینیشده مثبت (PPV): کسری از موارد مثبت که از بین تمام پیشبینیهای مثبت به درستی پیشبینی شدهاند. معمولاً به آن دقت میگویند و نشان دهنده احتمال یک پیشبینی مثبت صحیح است. با فرمول زیر ارائه میشود:

- نرخ کشف نادرست (FDR): کسری از پیشبینیهای مثبت که در واقع از بین همه پیشبینیهای مثبت منفی بودند. این احتمال یک پیشبینی مثبت اشتباه را نشان میدهد و با فرمول زیر ارائه میشود:

- ارزش پیشبینی شده منفی (NPV): کسری از موارد منفی که از بین تمام پیشبینیهای منفی به درستی پیشبینی شدهاند. احتمال یک پیشبینی منفی صحیح را نشان میدهد و با فرمول زیر ارائه میشود:

- نرخ حذف نادرست (FOR): کسری از پیشبینیهای منفی که در واقع از بین همه پیشبینیهای منفی مثبت بودند. احتمال یک پیشبینی منفی اشتباه را نشان میدهد و با فرمول زیر ارائه میشود:

- نرخ مثبت واقعی (TPR): کسری از موارد مثبت که از بین همه موارد مثبت به درستی پیشبینی شدهاست. معمولاً از آن به عنوان حساسیت یا یادآوری یاد میشود و احتمال دستهبندی صحیح موضوعات مثبت را نشان میدهد. با این فرمول نشان داده میشود:

- نرخ منفی کاذب (FNR): کسری از موارد مثبت که به اشتباه از بین همه موارد مثبت منفی پیشبینی شدهاست. احتمال دستهبندی نادرست موضوعات مثبت به عنوان موضوعات منفی را نشان میدهد و با این فرمول ارائه میشود:

- نرخ منفی واقعی (TNR): کسری از موارد منفی که از بین همه موارد منفی به درستی پیشبینی شدهاست. این احتمال را نشان میدهد که موضوعات منفی به درستی طبقهبندی شوند و با فرمول ارائه میشود:

- نرخ مثبت کاذب (FPR): کسری از موارد منفی که به اشتباه از بین همه موارد منفی مثبت پیشبینی شدهاست. احتمال دستهبندی نادرست موضوعات منفی به عنوان موضوعات مثبت را نشان میدهد و با این فرمول ارائه میشود:

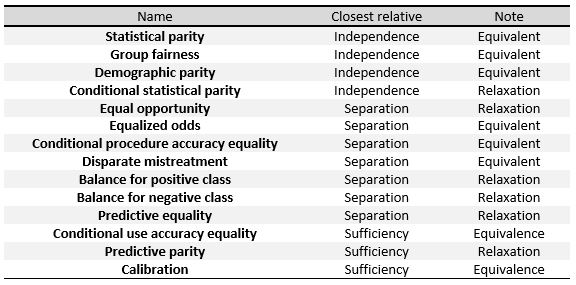

معیارهای زیر را میتوان معیارهای سه تعریف کلی ارائه شده در ابتدای این بخش یعنی استقلال، جدایی و کفایت دانست. در جدول[۱۱] سمت راست، روابط بین آنها را میبینیم.

برای تعریف دقیق این معیارها، همانطور که در Verma و همکاران انجام شد، آنها را به سه گروه بزرگ تقسیم میکنیم:[۱۲] تعاریف بر اساس یک نتیجه پیشبینی شده، بر اساس نتایج پیشبینی شده و واقعی، و تعاریف بر اساس احتمالات پیشبینی شده و نتیجه واقعی.

ما با یک طبقهبندی کننده باینری و نماد زیر کار خواهیم کرد: اشاره به نمره داده شده توسط طبقهبندی کننده است که احتمال قرار گرفتن یک موضوع خاص در کلاس مثبت یا منفی است. نشان دهنده طبقهبندی نهایی پیشبینی شده توسط الگوریتم است و مقدار آن معمولاً از مشتق میشود، برای مثال زمانی مثبت خواهد بود که بالاتر از یک آستانه مشخص باشد. نشان دهنده نتیجه واقعی است، یعنی طبقهبندی واقعی فرد و در نهایت، نشان دهنده ویژگیهای حساس موضوعات است.

تعاریف بر اساس نتیجه پیشبینی شده

[ویرایش]تعاریف در این بخش برای توزیعهای مختلف موضوعات بر یک نتیجه پیشبینی شده تمرکز دارد. آنها سادهترین و شهودیترین مفاهیم عدالت هستند.

- برابری جمعیتی که به آن برابری آماری، برابری نرخ پذیرش و معیار نیز گفته میشود. یک طبقهبندی کننده این تعریف را برآورده میکند اگر آزمودنیهای گروههای محافظتشده و محافظتنشده احتمال یکسانی برای انتساب به کلاس پیشبینیشده مثبت داشته باشند. این در صورتی است که فرمول زیر برآورده شود:

- برابری آماری مشروط اساساً شامل تعریف بالا است، اما فقط به زیر مجموعه ای از نمونهها محدود میشود. در نماد ریاضی این خواهد بود:

تعاریف بر اساس نتایج پیشبینی شده و واقعی

[ویرایش]این تعاریف نه تنها نتیجه پیشبینی شده را در نظر میگیرند بلکه آن را با نتیجه واقعی مقایسه کنید.

- برابری پیشبینی کننده که به آن نتیجه آزمون نیز گفته میشود. اگر افراد در گروههای محافظت شده و محافظت نشده دارای PPV برابر باشند، طبقهبندی کننده این تعریف را برآورده میکند. این در صورتی است که فرمول زیر برآورده شود:

- از نظر ریاضی، اگر یک طبقهبندی کننده دارای PPV برابر برای هر دو گروه باشد، FDR برابری نیز خواهد داشت که فرمول زیر را برآورده میکند:

- تعادل نرخ خطای مثبت کاذب، که به آن برابری پیشبینی نیز گفته میشود. اگر افراد در گروههای محافظتشده و محافظتنشده دارای FPR یکسان باشند، یک طبقهبندیکننده این تعریف را برآورده میکند. این در صورتی است که فرمول زیر برآورده شود:

- از نظر ریاضی، اگر یک طبقهبندی کننده FPR برابر برای هر دو گروه داشته باشد، TNR برابر نیز خواهد داشت که فرمول زیر را برآورده میکند:

- تعادل نرخ خطا منفی کاذب، همچنین به عنوان فرصت برابر نامیده میشود. اگر موضوعات در گروههای محافظت شده و محافظت نشده دارای FNR برابر باشند، یک طبقهبندی کننده این تعریف را برآورده میکند. این در صورتی است که فرمول زیر برآورده شود:

- از نظر ریاضی، اگر یک طبقهبندی کننده FNR برابر برای هر دو گروه داشته باشد، TPR برابر نیز خواهد داشت که فرمول زیر را برآورده میکند:

- شانس مساوی که به آن برابری دقت رویه مشروط و بدرفتاری نامتجانس نیز گفته میشود. یک طبقهبندی کننده این تعریف را برآورده میکند اگر افراد در گروههای محافظتشده و محافظتنشده دارای TPR برابر و FPR برابر باشند، که فرمول زیر را برآورده میکند:

- برابری دقت استفاده مشروط یک طبقهبندی کننده این تعریف را برآورده میکند اگر افراد در گروههای محافظتشده و محافظتنشده دارای PPV برابر و NPV برابر باشند، با فرمول:

- برابری دقت کلی یک طبقهبندی کننده این تعریف را برآورده میکند اگر موضوع در گروههای محافظتشده و محافظتنشده دقت پیشبینی برابری داشته باشد، یعنی احتمال اینکه موضوعی از یک کلاس به آن اختصاص داده شود. این در صورتی است که فرمول زیر را برآورده کند:

- برابری درمان یک طبقهبندی کننده این تعریف را برآورده میکند اگر افراد در گروههای محافظتشده و محافظتنشده نسبت برابری از FN و FP داشته باشند، که این فرمول را برآورده میکند:

تعاریف بر اساس احتمالات پیشبینی شده و نتیجه واقعی

[ویرایش]این تعاریف بر اساس نتیجه واقعی است و امتیاز احتمال پیشبینی شده.

- تست عدالت، که به عنوان کالیبراسیون یا تطبیق فرکانسهای شرطی نیز شناخته میشود. اگر افراد دارای امتیاز احتمال پیشبینیشده یکسان باشند، طبقهبندیکننده این تعریف را برآورده میکند زمانی که به گروه محافظت شده یا محافظت نشده تعلق دارند، احتمال یکسانی برای طبقهبندی در کلاس مثبت دارند:

- چاه کالیبراسیون بسط تعریف قبلی است. بیان میکند که وقتی افراد داخل یا خارج از گروه محافظت شده امتیاز احتمال پیشبینی شده یکسانی دارند آنها باید همان احتمال طبقهبندی در کلاس مثبت را داشته باشند و این احتمال باید برابر باشد :

- تعادل برای کلاس مثبت یک طبقهبندی کننده این تعریف را برآورده میکند اگر آزمودنیهای تشکیلدهنده کلاس مثبت از هر دو گروه محافظتشده و محافظتنشده دارای میانگین امتیاز احتمال پیشبینیشده برابر باشند. این بدان معنی است که مقدار مورد انتظار امتیاز احتمال برای گروههای محافظت شده و محافظت نشده با نتیجه واقعی مثبت یکسان است و فرمول زیر را برآورده میکند:

- تعادل برای کلاس منفی اگر آزمودنیهای تشکیلدهنده کلاس منفی از هر دو گروه محافظتشده و محافظتنشده دارای میانگین امتیاز احتمالی پیشبینیشده برابر باشند، طبقهبندیکننده این تعریف را برآورده میکند. این بدان معناست که مقدار مورد انتظار امتیاز احتمال برای گروههای محافظت شده و محافظت نشده با پیامد واقعی منفی یکسان است و فرمول زیر را برآورده میکند:

در حال پردازش

[ویرایش]روش دیگر اصلاح سوگیری در زمان تمرین است. این را میتوان با افزودن قیود به هدف بهینهسازی الگوریتم انجام داد.[۱۳] این محدودیتها الگوریتم را مجبور میکند تا با حفظ نرخهای یکسان اقدامات خاص برای گروه محافظتشده و بقیه افراد، عدالت را بهبود بخشد. برای مثال، میتوانیم این شرط را به هدف الگوریتم اضافه کنیم که نرخ مثبت کاذب برای افراد در گروه محافظت شده و افراد خارج از گروه محافظت شده یکسان باشد.

معیارهای اصلی مورد استفاده در این رویکرد، نرخ مثبت کاذب، نرخ منفی کاذب و نرخ کلی طبقهبندی اشتباه است. میتوان فقط یک یا چند مورد از این محدودیتها را به هدف الگوریتم اضافه کرد. توجه داشته باشید که برابری نرخهای منفی کاذب به معنای برابری نرخهای مثبت واقعی است، بنابراین این به معنای برابری فرصتها است. پس از افزودن محدودیتها به مشکل، ممکن است مشکل حل نشدنی شود، بنابراین ممکن است به آرامش در مورد آنها نیاز باشد.

این تکنیک نتایج خوبی در بهبود عدالت و در عین حال حفظ دقت بالا به دست میآورد و به برنامهنویس اجازه میدهد اقدامات عادلانه را برای بهبود انتخاب کند. با این حال، هر کار یادگیری ماشینی ممکن است به روش متفاوتی برای اعمال نیاز داشته باشد و کد موجود در طبقهبندیکننده باید اصلاح شود، که همیشه امکانپذیر نیست.[۱۴]

بیطرفی خصمانه

[ویرایش]ما دو طبقهبندیکننده را همزمان از طریق برخی روشهای مبتنی بر گرادیان (fe: gradient descent) آموزش میدهیم. اولین مورد، پیشبینی کننده تلاش میکند تا وظیفه پیشبینی را انجام دهد، متغیر هدف ، ورودی، با تغییر وزن آن برای به حداقل رساندن برخی از تابع از دست دادن داده شدهاست. مورد دوم، دشمن تلاش میکند تا وظیفه پیشبینی را انجام دهد، متغیر حساس، با تغییر وزن آن برای به حداقل رساندن برخی از تابع از دست دادن داده شدهاست.[۱۵][۱۶]

نکته مهم در اینجا این است که برای انتشار صحیح، در بالا باید به خروجی خام طبقهبندیکننده اشاره داشته باشد، نه پیشبینی گسسته. به عنوان مثال، با یک شبکه عصبی مصنوعی و یک مشکل طبقهبندی، میتواند به خروجی (تابع) بیشینه هموار اشاره کند.

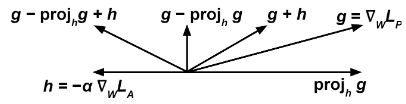

سپس به روز میکنیم را به حداقل رساندن در هر مرحله آموزش با توجه به گرادیان و ما را اصلاح میکنیم با توجه به عبارت:جایی که یک فراپارامتر قابل تنظیم است که میتواند در هر مرحله زمانی متفاوت باشد.

ایده شهودی این است که ما میخواهیم پیشبینیکننده سعی کند (اصطلاح عبارت )را به حداقل برساند در حالی که، در همان زمان، (اصطلاح عبارت )حداکثر است، بنابراین به طوری که دشمن در پیشبینی متغیر حساس از است.

عبارت مانع از حرکت پیشبینی کننده در جهتی میشود که به دشمن کمک میکند تا عملکرد ضرر خود را کاهش دهد.

میتوان نشان داد که آموزش مدل طبقهبندی پیشبینی کننده با این الگوریتم، برابری جمعیت شناختی را نسبت به آموزش آن بدون حریف بهبود میبخشد.

پس پردازش

[ویرایش]روش نهایی سعی در تصحیح نتایج یک طبقهبندی برای دستیابی به عدالت را دارد. در این روش ما یک طبقهبندی داریم که برای هر فرد یک امتیاز برمیگرداند و باید برای آنها یک پیشبینی باینری انجام دهیم. نمرات بالا احتمالاً نتیجه مثبت دارند، در حالی که نمرات پایین احتمالاً یک نتیجه منفی دارند، اما ما میتوانیم آستانه را تنظیم کنیم تا مشخص کنیم چه زمانی باید به صورت دلخواه پاسخ مثبت دهیم. توجه داشته باشید که تغییرات در مقدار آستانه بر مبادله بین نرخهای مثبت واقعی و منفی واقعی تأثیر میگذارد.

اگر تابع امتیاز عادلانه باشد به این معنا که مستقل از ویژگی محافظت شده باشد، در این صورت هر انتخاب آستانه نیز عادلانه خواهد بود، اما طبقهبندیکنندههای این نوع تمایل به جانبداری دارند، بنابراین ممکن است آستانه متفاوتی برای هر گروه محافظت شده لازم باشد. برای رسیدن به عدالت[۱۷] یک راه برای انجام این کار ترسیم نرخ مثبت واقعی در برابر نرخ منفی کاذب در تنظیمات آستانههای مختلف (به این منحنی ROC گفته میشود) و یافتن آستانه ای است که در آن نرخ برای گروه محافظت شده و سایر افراد برابر است.[۱۷]

از مزایای پس پردازش میتوان به این نکته اشاره کرد که این تکنیک میتواند بعد از هر طبقهبندی کننده، بدون تغییر آن اعمال شود و عملکرد خوبی در معیارهای عدالت دارد. معایب نیاز به دسترسی به ویژگی محافظت شده در زمان آزمایش و عدم انتخاب در تعادل بین دقت و عدالت است.[۱۴]

رد کردن طبقهبندی بر اساس گزینه

[ویرایش]با توجه به طبقهبندی اجازه دهید احتمال محاسبه شده توسط طبقهبندی کنندهها به عنوان احتمالی باشد که نمونه متعلق به کلاس مثبت + است. چه زمانی نزدیک به ۱ یا ۰ است، نمونه با درجه اطمینان بالا به ترتیب متعلق به کلاس + یا - مشخص شدهاست. با این حال، زمانی که نزدیکتر به ۰٫۵ است طبقهبندی نامشخص تر است.[۱۸]

ما میگوییم یک "مثال رد شده" است اگر با معین به طوری که .

الگوریتم "ROC" شامل طبقهبندی نمونههای رد نشده طبق قانون بالا و نمونههای رد شده به شرح زیر است: اگر نمونه نمونه ای از یک گروه محروم باشد () سپس آن را به عنوان مثبت و در غیر این صورت برچسب منفی بزنید.

ما میتوانیم معیارهای مختلف تبعیض (پیوند) را به عنوان توابعی از بهینه کنیم برای یافتن بهینه برای هر مشکلی و اجتناب از تبعیض آمیز شدن علیه گروه ممتاز.[۱۸]

جستارهای وابسته

[ویرایش]- تعصب الگوریتمی (Algorithmic bias)

- فراگیری ماشین

منابع

[ویرایش]- ↑ Moritz Hardt, Berkeley. Retrieved 18 December 2019

- ↑ "IBM AI Fairness 360 open source toolkit adds new functionalities". Tech Republic.

- ↑ IBM AI Fairness 360 بایگانیشده در ۲۹ ژوئن ۲۰۲۲ توسط Wayback Machine. Retrieved 18 December 2019

- ↑ Fairness Flow el detector de sesgos de Facebook. Retrieved 28 December 2019

- ↑ ML-Fairness gym. Retrieved 18 December 2019

- ↑ "Attorney General Eric Holder Speaks at the National Association of Criminal Defense Lawyers 57th Annual Meeting and 13th State Criminal Justice Network Conference". www.justice.gov (به انگلیسی). 2014-08-01. Retrieved 2022-04-16.

- ↑ Mattu, Julia Angwin,Jeff Larson,Lauren Kirchner,Surya. "Machine Bias". ProPublica (به انگلیسی). Retrieved 2022-04-16.

- ↑ Rose, Adam (2010-01-22). "Breaking News, Analysis, Politics, Blogs, News Photos, Video, Tech Reviews". Time (به انگلیسی). ISSN 0040-781X. Retrieved 2022-04-16.

- ↑ "Google says sorry for racist auto-tag in photo app". the Guardian (به انگلیسی). 2015-07-01. Retrieved 2022-04-16.

- ↑ "A beauty contest was judged by AI and the robots didn't like dark skin". the Guardian (به انگلیسی). 2016-09-08. Retrieved 2022-04-16.

- ↑ ۱۱٫۰ ۱۱٫۱ ۱۱٫۲ Solon Barocas; Moritz Hardt; Arvind Narayanan, Fairness and Machine Learning. Retrieved 15 December 2019.

- ↑ ۱۲٫۰ ۱۲٫۱ Verma, Sahil, and Julia Rubin. "Fairness definitions explained." In 2018 IEEE/ACM international workshop on software fairness (fairware), pp. 1-7. IEEE, 2018.

- ↑ Muhammad Bilal Zafar; Isabel Valera; Manuel Gómez Rodríguez; Krishna P. Gummadi, Fairness Beyond Disparate Treatment & Disparate Impact: Learning Classification without Disparate Mistreatment بایگانیشده در ۱۰ آوریل ۲۰۲۲ توسط Wayback Machine. Retrieved 1 December 2019

- ↑ ۱۴٫۰ ۱۴٫۱ Ziyuan Zhong, Tutorial on Fairness in Machine Learning. Retrieved 1 December 2019

- ↑ ۱۵٫۰ ۱۵٫۱ Brian Hu Zhang; Blake Lemoine; Margaret Mitchell, Mitigating Unwanted Biases with Adversarial Learning. Retrieved 17 December 2019

- ↑ Joyce Xu, Algorithmic Solutions to Algorithmic Bias: A Technical Guide. Retrieved 17 December 2019

- ↑ ۱۷٫۰ ۱۷٫۱ Moritz Hardt; Eric Price; Nathan Srebro, Equality of Opportunity in Supervised Learning. Retrieved 1 December 2019

- ↑ ۱۸٫۰ ۱۸٫۱ Faisal Kamiran; Asim Karim; Xiangliang Zhang, Decision Theory for Discrimination-aware Classification. Retrieved 17 December 2019

French

French Deutsch

Deutsch