Web analytics

Con web analytics (traducibile come: analitiche per il web) si identifica un sistema di tracciamento dei visitatori di un sito web, mirato alla profilazione dell'utente per finalità statistiche o per effettuare marketing mirato.[1][2]

Matomo è un esempio di software libero per effettuare web analytics.[3]

Consiste nella misurazione, raccolta, analisi e reporting dei dati web per comprendere e ottimizzare l'utilizzo del web. La web analytics non è solo un processo per misurare il traffico web, ma può essere utilizzata come strumento per ricerche commerciali e di mercato e per valutare e migliorare l'efficacia del sito web. Le applicazioni di analisi dei dati web possono anche aiutare le aziende a misurare i risultati delle tradizionali campagne pubblicitarie su stampa o trasmissione. Può essere utilizzato per stimare come cambia il traffico verso un sito web dopo il lancio di una nuova campagna pubblicitaria. L'analisi dei dati web fornisce informazioni sul numero di visitatori di un sito Web e sul numero di visualizzazioni di pagina. Aiuta a misurare le tendenze del traffico e della popolarità, il che è utile per le ricerche di mercato.

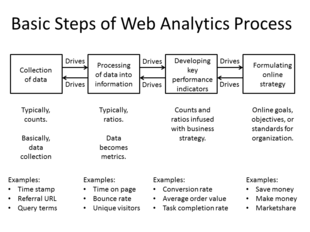

Passaggi di base del processo di analisi dei dati web[modifica | modifica wikitesto]

La maggior parte dei processi di analisi dei dati web si riduce a quattro fasi o passaggi essenziali, che sono[4]:

- Raccolta di dati: questa fase è la raccolta dei dati di base, elementari. Di solito, questi dati sono conti di cose. L'obiettivo di questa fase è raccogliere i dati.

- Elaborazione dei dati in informazioni: questa fase di solito prende i conteggi e li rende rapporti, sebbene possano esserci ancora alcuni conteggi. L'obiettivo di questa fase è prendere i dati e conformarli in informazioni, in particolare metriche.

- Sviluppo di KPI: questa fase si concentra sull'utilizzo dei rapporti (e conteggi) e sull'infusione di essi con strategie aziendali, denominate indicatori chiave di prestazione (KPI). Molte volte, i KPI si occupano degli aspetti di conversione, ma non sempre. Dipende dall'organizzazione.

- Formulazione della strategia online: questa fase riguarda gli obiettivi, gli obiettivi e gli standard online per l'organizzazione o l'azienda. Queste strategie sono generalmente correlate al guadagno, al risparmio o all'aumento della quota di mercato.

Un'altra funzione essenziale sviluppata dagli analisti per l'ottimizzazione dei siti web sono gli esperimenti

- Esperimenti e test: il test A/B è un esperimento controllato con due varianti, in impostazioni online, come lo sviluppo web.

L'obiettivo del test A/B è identificare e suggerire modifiche alle pagine web che aumentano o massimizzano l'effetto di un risultato di interesse testato statisticamente.

Ogni fase influisce o può influire (ovvero, guida) la fase precedente o successiva. Quindi, a volte i dati disponibili per la raccolta influiscono sulla strategia online. Altre volte, la strategia online influisce sui dati raccolti.

Tecnologie di analisi dei dati web[modifica | modifica wikitesto]

Esistono almeno due categorie di analisi web, analisi web off-site e on-site.

- Off-site web analytics si riferisce alla misurazione e all'analisi del web indipendentemente dal fatto che una persona possieda o gestisca un sito web. Include la misurazione del pubblico potenziale di un sito Web (opportunità), della condivisione della voce (visibilità) e del buzz (commenti) che si verificano su Internet nel suo complesso.

- On-site web analytics, la più comune delle due, misura il comportamento di un visitatore una volta su un sito web specifico. Ciò include i suoi driver e conversioni; ad esempio, il grado in cui le landing pages sono associate agli acquisti online. L'analisi on-site misura le prestazioni di un sito web specifico in un contesto commerciale. Questi dati vengono in genere confrontati con gli indicatori chiave di prestazione per le prestazioni e vengono utilizzati per migliorare la risposta del pubblico di un sito Web o di una campagna di marketing. Google Analytics e Adobe Analytics sono il servizio di analisi on-site più utilizzato; sebbene stiano emergendo nuovi strumenti che forniscono ulteriori livelli di informazioni, comprese le mappe termiche e la riproduzione della sessione.

Storicamente, l'analisi dei dati web è stata utilizzata per fare riferimento alla misurazione dei visitatori sul sito. Tuttavia, questo significato è diventato sfumato, principalmente perché i fornitori stanno producendo strumenti che abbracciano entrambe le categorie. Molti fornitori diversi forniscono software e servizi di analisi on-site. Esistono due modi tecnici principali per raccogliere i dati. Il primo e tradizionale metodo, l'analisi dei logfiles del server, legge i logfiles in cui il server web registra le richieste di file dai browser. Il secondo metodo, la codifica delle pagine, utilizza JavaScript incorporato nella pagina Web per effettuare richieste di immagini a un server dedicato all'analisi di terze parti, ogni volta che una pagina Web viene visualizzata da un browser web o, se lo si desidera, quando si verifica un clic del mouse. Entrambi raccolgono dati che possono essere elaborati per produrre report sul traffico web.

Fonti di dati di analisi dei dati web[modifica | modifica wikitesto]

L'obiettivo fondamentale dell'analisi dei dati web è raccogliere e analizzare i dati relativi al traffico web e ai modelli di utilizzo. I dati provengono principalmente da quattro fonti:

- Dati di richiesta HTTP diretti: provengono direttamente dai messaggi di richiesta HTTP (intestazioni di richiesta HTTP).

- Dati a livello di rete e generati dal server associati alle richieste HTTP: non fanno parte di una richiesta HTTP, ma sono necessari per la corretta trasmissione delle richieste, ad esempio l'indirizzo IP di un richiedente.

- Dati a livello di applicazione inviati con richieste HTTP: generati ed elaborati da programmi a livello di applicazione (come JavaScript, PHP e ASP.Net), incluse sessioni e riferimenti. Questi vengono solitamente acquisiti da log interni piuttosto che da servizi di analisi web pubblici.

- Dati esterni: possono essere combinati con i dati sul sito per aiutare ad aumentare i dati sul comportamento del sito web descritti sopra e interpretare l'utilizzo del web. Ad esempio, gli indirizzi IP sono generalmente associati a regioni geografiche e provider di servizi Internet, percentuali di clic e di apertura della posta elettronica, dati delle campagne di direct mail, cronologia delle vendite e dei lead o altri tipi di dati secondo necessità.

Analisi dei logfiles del server web[modifica | modifica wikitesto]

I server Web registrano alcune delle loro transazioni in un logfile. Ci si rese presto conto che questi logfiles potevano essere letti da un programma per fornire dati sulla popolarità del sito web. Così è nato il software di analisi dei log web.

All'inizio degli anni '90, le statistiche del sito web consistevano principalmente nel conteggio del numero di richieste (o visite) dei client effettuate al server web. Inizialmente si trattava di un metodo ragionevole, poiché ogni sito Web era spesso costituito da un singolo file HTML. Tuttavia, con l'introduzione di immagini in HTML e di siti Web che si estendevano su più file HTML, questo conteggio è diventato meno utile. Il primo vero analizzatore di log commerciale è stato rilasciato da IPRO nel 1994[5].

Due unità di misura sono state introdotte a metà degli anni '90 per misurare con maggiore precisione la quantità di attività umana sui server web. Si trattava di visualizzazioni di pagina e visite (o sessioni). Una visualizzazione di pagina era definita come una richiesta fatta al web server per una pagina, al contrario di un grafico, mentre una visita era definita come una sequenza di richieste da un client identificato in modo univoco che scadeva dopo un certo periodo di inattività, solitamente 30 minuti.

L'emergere di spider e robot dei motori di ricerca alla fine degli anni '90, insieme a proxy web e indirizzi IP assegnati dinamicamente per grandi aziende e ISP, ha reso più difficile identificare i visitatori umani unici di un sito web.

L'ampio uso di cache Web ha anche presentato un problema per l'analisi dei logfiles. Se una persona visita nuovamente una pagina, la seconda richiesta verrà spesso recuperata dalla cache del browser, quindi nessuna richiesta verrà ricevuta dal server web. Ciò significa che il percorso della persona attraverso il sito è perso. La memorizzazione nella cache può essere annullata configurando il server Web, ma ciò può comportare una riduzione delle prestazioni per il visitatore e un carico maggiore sui server[6].

Codifica della pagina[modifica | modifica wikitesto]

Le preoccupazioni circa l'accuratezza dell'analisi dei logfiles in presenza di memorizzazione nella cache e il desiderio di poter eseguire analisi web come servizio in outsourcing, hanno portato al secondo metodo di raccolta dati, il tagging delle pagine o "Web bug".

A metà degli anni '90, i contatori Web erano comunemente visti: si trattava di immagini incluse in una pagina Web che mostrava il numero di volte in cui l'immagine era stata richiesta, che era una stima del numero di visite a quella pagina. Alla fine degli anni '90, questo concetto si è evoluto per includere una piccola immagine invisibile invece di una visibile e, utilizzando JavaScript, per trasmettere alla richiesta di immagine determinate informazioni sulla pagina e sul visitatore. Queste informazioni possono quindi essere elaborate in remoto da una società di analisi dei dati web e vengono generate statistiche dettagliate.

Il servizio di web analytics gestisce anche il processo di assegnazione di un cookie all'utente, che può identificarlo univocamente durante la sua visita e nelle visite successive. I tassi di accettazione dei cookie variano in modo significativo tra i siti Web e possono influire sulla qualità dei dati raccolti e riportati.

La raccolta dei dati del sito Web utilizzando un server di raccolta dati di terze parti (o anche un server di raccolta dati interno) richiede un'ulteriore ricerca DNS da parte del computer dell'utente per determinare l'indirizzo IP del server di raccolta. A volte, i ritardi nel completamento di una ricerca DNS riuscita o non riuscita possono comportare la mancata raccolta dei dati.

Con la crescente popolarità delle soluzioni basate su Ajax, un'alternativa all'uso di un'immagine invisibile è implementare una chiamata al server dalla pagina renderizzata. In questo caso, quando la pagina viene visualizzata sul browser web, un pezzo di codice Ajax richiama il server e passa le informazioni sul client che possono quindi essere aggregate da una società di analisi dei dati web. Questo è in qualche modo viziato dalle restrizioni del browser sui server che possono essere contattati con oggetti XmlHttpRequest. Inoltre, questo metodo può portare a livelli di traffico segnalati leggermente inferiori, poiché il visitatore potrebbe interrompere il caricamento della pagina a metà della risposta prima che venga effettuata la chiamata Ajax.

Logfile analysis e page tagging[modifica | modifica wikitesto]

Sia i programmi di logfile che le soluzioni di tagging delle pagine sono prontamente disponibili per le aziende che desiderano eseguire analisi web. In alcuni casi, la stessa società di analisi dei dati web offrirà entrambi gli approcci. Ci sono vantaggi e svantaggi per ogni approccio[7].

Vantaggi dell'analisi dei logfiles[modifica | modifica wikitesto]

I principali vantaggi dell'analisi dei logfiles rispetto al tagging delle pagine sono i seguenti:

- Il server Web normalmente produce già logfiles, quindi i dati grezzi sono già disponibili. Non sono richieste modifiche al sito web.

- I dati si trovano sui server dell'azienda e sono in un formato standard, piuttosto che proprietario. Ciò rende facile per un'azienda cambiare programma in un secondo momento, utilizzare diversi programmi diversi e analizzare i dati storici con un nuovo programma.

- I logfiles contengono informazioni sulle visite degli spider dei motori di ricerca, che generalmente sono esclusi dagli strumenti di analisi che utilizzano la codifica JavaScript. Sebbene questi non debbano essere segnalati come parte dell'attività umana, si tratta di informazioni utili per l'ottimizzazione dei motori di ricerca.

- I logfiles non richiedono ulteriori ricerche DNS o avviamenti lenti TCP. Pertanto non ci sono chiamate al server esterno che possono rallentare la velocità di caricamento della pagina o comportare un numero illimitato di visualizzazioni di pagina.

- Il server web registra in modo affidabile ogni transazione che effettua, ad esempio, servendo documenti PDF e contenuti generati da script, e non si basa sulla collaborazione dei browser dei visitatori.

Vantaggi del page tagging[modifica | modifica wikitesto]

I principali vantaggi del tagging delle pagine rispetto all'analisi dei logfiles sono i seguenti:

- Il conteggio si attiva aprendo la pagina (dato che il web client esegue gli script di tag), non richiedendolo al server. Se una pagina è memorizzata nella cache, non verrà conteggiata dall'analisi dei log basata sul server. Le pagine memorizzate nella cache possono rappresentare fino a un terzo di tutte le visualizzazioni di pagina, il che può avere un impatto negativo su molte metriche del sito.

- Lo script può avere accesso a informazioni aggiuntive sul client Web o sull'utente, non inviate nella query, come le dimensioni dello schermo dei visitatori e il prezzo dei prodotti acquistati.

- Il tagging della pagina può segnalare eventi che non comportano una richiesta al server web, completamento parziale di moduli, eventi del mouse come onClick, onMouseOver, onFocus, onBlur ecc.

- Il servizio di tagging delle pagine gestisce il processo di assegnazione dei cookie ai visitatori; con l'analisi del logfiles, il server deve essere configurato per farlo.

- La codifica delle pagine è disponibile per le aziende che non hanno accesso ai propri server web.

- Ultimamente, la codifica delle pagine è diventata uno standard nell'analisi dei dati web.

Fattori economici[modifica | modifica wikitesto]

L'analisi dei logfiles viene quasi sempre eseguita internamente. La codifica delle pagine può essere eseguita internamente, ma più spesso è fornita come servizio di terze parti. La differenza economica tra questi due modelli può anche essere una considerazione per un'azienda che decide quale acquistare.

- Per l'analisi dei logfiles i dati devono essere archiviati e archiviati, che spesso si ingrandiscono rapidamente. Sebbene il costo dell'hardware per eseguire questa operazione sia minimo, il sovraccarico per un reparto IT può essere considerevole.

- Per l'analisi dei logfiles è necessario mantenere il software, inclusi aggiornamenti e patch di sicurezza.

- I fornitori di tag di pagine complesse addebitano una tariffa mensile in base al volume, ovvero al numero di visualizzazioni di pagina raccolte al mese.

Quale soluzione sia più economica da implementare dipende dalla quantità di competenze tecniche all'interno dell'azienda, dal fornitore scelto, dalla quantità di attività visualizzata sui siti Web, dalla profondità e dal tipo di informazioni ricercate e dal numero di siti Web distinti che necessitano di statistiche.

Indipendentemente dalla soluzione del fornitore o dal metodo di raccolta dati utilizzato, è necessario includere anche il costo dell'analisi e dell'interpretazione dei visitatori Web. Cioè, il costo per trasformare i dati grezzi in informazioni utilizzabili. Ciò può derivare dall'utilizzo di consulenti di terze parti, dall'assunzione di un analista web esperto o dalla formazione di una persona interna idonea. È quindi possibile eseguire un'analisi costi-benefici. Ad esempio, quale aumento delle entrate o risparmio sui costi è possibile ottenere analizzando i dati dei visitatori Web?

Geolocalizzazione dei visitatori[modifica | modifica wikitesto]

Con la geolocalizzazione IP è possibile tracciare la posizione dei visitatori. Utilizzando il database di geolocalizzazione IP o l'API, i visitatori possono essere geolocalizzati a livello di città, regione o paese.

IP Intelligence, o Internet Protocol (IP) Intelligence, è una tecnologia che mappa Internet e classifica gli indirizzi IP in base a parametri quali posizione geografica (paese, regione, stato, città e codice postale), tipo di connessione, provider di servizi Internet (ISP), informazioni proxy e altro ancora. La prima generazione di IP Intelligence era denominata tecnologia di targeting geografico o geolocalizzazione. Queste informazioni vengono utilizzate dalle aziende per la segmentazione del pubblico online in applicazioni quali pubblicità online, targeting comportamentale, localizzazione di contenuti (o localizzazione di siti Web), gestione dei diritti digitali, personalizzazione, rilevamento di frodi online, ricerca localizzata, analisi avanzate, gestione del traffico globale e distribuzione dei contenuti.

Analisi dei clic[modifica | modifica wikitesto]

Analisi del percorso di clic con pagine di riferimento a sinistra e frecce e rettangoli che differiscono per spessore e estensione per simboleggiare la quantità di movimento. L'analisi dei clic è un tipo speciale di analisi dei dati web che presta particolare attenzione ai clic.

Comunemente, l'analisi dei clic si concentra sull'analisi on-site. Un editore di un sito web utilizza l'analisi dei clic per determinare le prestazioni del suo particolare sito, rispetto a dove gli utenti del sito stanno facendo clic.

Inoltre, l'analisi dei clic può avvenire in tempo reale o "irreale", a seconda del tipo di informazioni ricercate. In genere, gli editori di prima pagina sui siti di notizie ad alto traffico vorranno monitorare le loro pagine in tempo reale, per ottimizzare il contenuto. Editori, designer o altri tipi di stakeholder possono analizzare i clic su un arco di tempo più ampio per aiutarli a valutare le prestazioni di scrittori, elementi di design o pubblicità, ecc.

I dati sui clic possono essere raccolti in almeno due modi. Idealmente, un clic viene "registrato" quando si verifica e questo metodo richiede alcune funzionalità che raccolgono le informazioni rilevanti quando si verifica l'evento. In alternativa, si può ipotizzare che una visualizzazione di pagina sia il risultato di un clic e quindi registrare un clic simulato che ha portato a quella visualizzazione di pagina.

Altri metodi[modifica | modifica wikitesto]

A volte vengono utilizzati altri metodi di raccolta dei dati. Lo sniffing raccoglie i dati rilevando il traffico di rete che passa tra il server Web e il mondo esterno. Lo sniffing non comporta modifiche alle pagine Web o ai server Web. È anche possibile integrare l'analisi web nel software del server web stesso. Entrambi questi metodi affermano di fornire dati in tempo reale migliori rispetto ad altri metodi.

Analisi web on-site: definizioni[modifica | modifica wikitesto]

Non ci sono definizioni concordate a livello globale all'interno dell'analisi dei dati web poiché gli enti del settore hanno cercato di concordare definizioni utili e definitive per qualche tempo. I principali organismi che hanno avuto input in questo settore sono stati IAB (Interactive Advertising Bureau), JICWEBS (The Joint Industry Committee for Web Standards in the UK and Ireland) e The DAA (Digital Analytics Association), formalmente noto come WAA (Web Analytics Association, USA). Tuttavia, molti termini vengono utilizzati in modo coerente da uno strumento di analisi principale a un altro, quindi il seguente elenco, basato su tali convenzioni, può essere un utile punto di partenza:

- Frequenza di rimbalzo: la percentuale di visite che sono visite di una sola pagina e senza altre interazioni (clic) su quella pagina. In altre parole, un singolo clic in una particolare sessione è chiamato rimbalzo.

- Click path: la sequenza cronologica delle visualizzazioni di pagina all'interno di una visita o sessione.

- Hit: richiesta di un file dal server web. Disponibile solo nell'analisi dei log. Il numero di visite ricevute da un sito Web viene spesso citato per affermarne la popolarità, ma questo numero è estremamente fuorviante e sovrastima notevolmente la popolarità. Una singola pagina Web consiste tipicamente di più (spesso dozzine) di file discreti, ognuno dei quali viene conteggiato come hit quando la pagina viene scaricata, quindi il numero di hit è in realtà un numero arbitrario che riflette maggiormente la complessità delle singole pagine su il sito web rispetto alla popolarità effettiva del sito web. Il numero totale di visite o visualizzazioni di pagina fornisce una valutazione più realistica e accurata della popolarità.

- Visualizzazione pagina: una richiesta di un file o, talvolta, un evento come un clic del mouse, definito come una pagina nella configurazione dello strumento di analisi dei dati web. Un'occorrenza dello script in esecuzione nel tagging della pagina. Nell'analisi dei log, la visualizzazione di una singola pagina può generare più hit poiché tutte le risorse necessarie per visualizzare la pagina (immagini, file.js e.css) vengono richieste anche dal server web.

- Visitatore/Visitatore unico/Utente unico: Il cliente identificato in modo univoco che sta generando visualizzazioni di pagina o hit entro un periodo di tempo definito (ad es. giorno, settimana o mese). Un client identificato in modo univoco è solitamente una combinazione di una macchina (ad esempio il proprio computer desktop al lavoro) e un browser (Firefox su quella macchina). L'identificazione avviene solitamente tramite un cookie persistente che è stato immesso sul computer dal codice della pagina del sito. Un metodo precedente, utilizzato nell'analisi dei logfiles, è la combinazione univoca dell'indirizzo IP del computer e delle informazioni sull'agente utente (browser) fornite al server Web dal browser. È importante capire che il "Visitatore" non è lo stesso essere umano seduto al computer al momento della visita, poiché un individuo umano può utilizzare computer diversi o, sullo stesso computer, può utilizzare browser diversi, e sarà visto come un visitatore diverso in ogni circostanza.

- Visita/sessione: una visita o sessione è definita come una serie di richieste di pagina o, nel caso di tag, richieste di immagini dallo stesso cliente identificato in modo univoco. Un client univoco viene comunemente identificato da un indirizzo IP o da un ID univoco inserito nel cookie del browser. Una visita è considerata conclusa quando non sono state registrate richieste in un certo numero di minuti trascorsi. Un limite di 30 minuti ("time out") viene utilizzato da molti strumenti di analisi ma può, in alcuni strumenti (come Google Analytics), essere modificato in un altro numero di minuti. I raccoglitori di dati di analisi e gli strumenti di analisi non hanno un modo affidabile per sapere se un visitatore ha guardato altri siti tra le visualizzazioni di pagina; una visita è considerata una visita fintanto che gli eventi (visualizzazioni di pagina, clic, qualunque cosa venga registrata) sono più vicini tra loro di 30 minuti o meno. Tieni presente che una visita può consistere in una visualizzazione di una pagina o migliaia. La sessione di una visita unica può anche essere prolungata se il tempo tra i caricamenti della pagina indica che un visitatore ha visualizzato le pagine continuamente.

- Tempo attivo/Tempo di coinvolgimento: tempo medio che i visitatori trascorrono effettivamente a interagire con i contenuti di una pagina Web, in base ai movimenti del mouse, ai clic, al passaggio del mouse e agli scorrimenti. A differenza di Durata sessione e Durata visualizzazione pagina/Tempo sulla pagina, questa metrica può misurare con precisione la durata del coinvolgimento nella visualizzazione della pagina finale, ma non è disponibile in molti strumenti di analisi o metodi di raccolta dati.

- Profondità media della pagina/Visualizzazioni di pagina per sessione media: la profondità della pagina è la "dimensione" approssimativa di una visita media, calcolata dividendo il numero totale di visualizzazioni di pagina per il numero totale di visite.

- Durata media della visualizzazione della pagina: tempo medio che i visitatori trascorrono su una pagina media del sito.

- Click: si riferisce a una singola istanza di un utente che segue un collegamento ipertestuale da una pagina in un sito a un'altra".

- Evento: un'azione distinta o una classe di azioni che si verificano su un sito Web. Una visualizzazione di pagina è un tipo di evento. Gli eventi incapsulano anche clic, invii di moduli, eventi di pressione di tasti e altre azioni dell'utente lato client.

- Tasso di uscita/percentuale di uscita: statistica applicata a una singola pagina, non a un sito web. La percentuale di visite che visualizzano una pagina in cui quella pagina è l'ultima pagina visualizzata nella visita.

- Prima visita/Prima sessione: chiamata anche "Visitatore unico assoluto" in alcuni strumenti. Una visita da un cliente identificato in modo univoco che teoricamente non ha effettuato alcuna visita precedente. Poiché l'unico modo per sapere se il cliente identificato in modo univoco è stato sul sito in precedenza è la presenza di un cookie persistente o tramite fingerprinting digitale che era stato ricevuto in una visita precedente, l'etichetta Prima visita non è affidabile se i cookie del sito sono stati cancellati dalla loro precedente visita.

- Frequenza/sessione per univoco: la frequenza misura la frequenza con cui i visitatori visitano un sito Web in un determinato periodo di tempo. Viene calcolato dividendo il numero totale di sessioni (o visite) per il numero totale di visitatori unici durante un periodo di tempo specificato, ad esempio un mese o un anno. A volte è usato come intercambiabile con il termine "lealtà".

- Impression: la definizione più comune di "impressione" è un'istanza di un annuncio che appare su una pagina visualizzata. Si noti che un annuncio pubblicitario può essere visualizzato su una pagina visualizzata sotto l'area effettivamente visualizzata sullo schermo, quindi la maggior parte delle misurazioni delle impressioni non significa necessariamente che un annuncio sia stato visualizzabile.

- Nuovo visitatore: un visitatore che non ha effettuato visite precedenti. Questa definizione crea una certa confusione (vedi confusioni comuni di seguito) e talvolta viene sostituita dall'analisi delle prime visite.

- Tempo di visualizzazione della pagina/Tempo di visibilità della pagina/Durata di visualizzazione della pagina: il tempo di permanenza di una singola pagina (o un blog, banner pubblicitario...) sullo schermo, misurato come la differenza calcolata tra il tempo della richiesta per quella pagina e il tempo della successiva richiesta registrata. Se non è presente alcuna richiesta registrata successiva, il tempo di visualizzazione di quell'istanza di quella pagina non viene incluso nei rapporti.

- Repeat Visitor: un visitatore che ha effettuato almeno una visita precedente. Il periodo tra l'ultima visita e quella corrente è chiamato recency del visitatore e viene misurato in giorni.

- Return Visitor: un visitatore unico con attività consistente in una visita a un sito durante un periodo del rapporto e in cui il visitatore unico ha visitato il sito prima del periodo del rapporto. L'individuo viene conteggiato una sola volta durante il periodo di rendicontazione.

- Durata della sessione/Durata della visita: tempo medio che i visitatori trascorrono sul sito ogni volta che visitano, calcolato come la somma totale della durata di tutte le sessioni divisa per il numero totale di sessioni.

- Single Page Visit/Singleton: una visita in cui viene visualizzata solo una singola pagina (non si tratta di un "rimbalzo").

- Site Overlay è una tecnica di report in cui le statistiche (clic) o gli hot spot vengono sovrapposti, in base alla posizione fisica, a un'istantanea visiva della pagina web.

- Click-through Rate è un rapporto tra gli utenti che fanno clic su un collegamento specifico e il numero totale di utenti che visualizzano una pagina, un'e-mail o un annuncio pubblicitario. Viene comunemente utilizzato per misurare il successo di una campagna pubblicitaria online per un determinato sito Web, nonché l'efficacia delle campagne e-mail.

Analisi dei dati web off-site[modifica | modifica wikitesto]

L'analisi dei dati web off-site si basa sull'analisi dei dati aperti, sull'esplorazione dei social media e sulla condivisione della voce sulle proprietà web. Di solito viene utilizzato per capire come commercializzare un sito identificando le parole chiave taggate a questo sito, sia dai social media che da altri siti web.

Utilizzando HTTP Referer, i proprietari di pagine web saranno in grado di tracciare quali sono i siti referrer che aiutano a portare traffico al proprio sito.

Fonti comuni di confusione nell'analisi dei dati web[modifica | modifica wikitesto]

Il problema dell'hotel[modifica | modifica wikitesto]

Il problema dell'hotel è generalmente il primo problema riscontrato da un utente di web analytics. Il problema è che i visitatori unici per ogni giorno in un mese non si sommano allo stesso totale dei visitatori unici per quel mese. A un utente inesperto questo sembra essere un problema in qualunque software di analisi stia utilizzando. In effetti è una semplice proprietà delle definizioni metriche.

Il modo per immaginare la situazione è immaginare un hotel. L'hotel dispone di due camere (Camera A e Camera B).

| Giorno 01 | Giorno 02 | Giorno 03 | Totale | |

|---|---|---|---|---|

| Camera A | John | John | Mark | 2 utenti unici |

| Camera B | Mark | Anne | Anne | 2 utenti unici |

| Totale | 2 | 2 | 2 | ? |

Come mostra la tabella, l'hotel ha due utenti unici ogni giorno per tre giorni. La somma dei totali rispetto ai giorni è quindi sei.

Ogni camera ha avuto nel periodo due utenti unici. La somma dei totali rispetto alle stanze è quindi quattro.

In realtà solo tre visitatori sono stati nell'hotel durante questo periodo. Il problema è che una persona che rimane in una stanza per due notti verrà conteggiata due volte se viene contata una volta al giorno, ma viene conteggiata solo una volta se si guarda al totale per il periodo. Qualsiasi software per l'analisi dei dati web li sommerà correttamente per il periodo di tempo scelto, portando così al problema quando un utente cerca di confrontare i totali.

Metodi di analisi dei dati web[modifica | modifica wikitesto]

Problemi con i cookie[modifica | modifica wikitesto]

Storicamente, i fornitori di soluzioni di analisi dei tag delle pagine hanno utilizzato cookie di terze parti inviati dal dominio del fornitore invece del dominio del sito web che si sta navigando. I cookie di terze parti possono gestire i visitatori che attraversano più domini non correlati all'interno del sito dell'azienda, poiché il cookie è sempre gestito dai server del fornitore.

Tuttavia, i cookie di terze parti in linea di principio consentono di tracciare un singolo utente attraverso i siti di diverse società, consentendo al fornitore di analisi di raccogliere l'attività dell'utente sui siti in cui ha fornito informazioni personali con la sua attività su altri siti in cui pensava di essere anonimo. Sebbene le società di analisi dei dati web neghino di farlo, altre società come le società che forniscono banner pubblicitari lo hanno fatto. Le preoccupazioni in materia di privacy relative ai cookie hanno quindi portato una notevole minoranza di utenti a bloccare o eliminare i cookie di terze parti. Nel 2005, alcuni rapporti hanno mostrato che circa il 28% degli utenti di Internet ha bloccato i cookie di terze parti e il 22% li ha cancellati almeno una volta al mese[8]. La maggior parte dei fornitori di soluzioni per la codifica delle pagine si è ora spostata per fornire almeno l'opzione di utilizzo cookie di prima parte (cookie assegnati dal sottodominio del cliente).

Un altro problema è l'eliminazione dei cookie. Quando l'analisi web dipende dai cookie per identificare i visitatori unici, le statistiche dipendono da un cookie persistente per contenere un ID visitatore univoco. Quando gli utenti eliminano i cookie, di solito eliminano sia i cookie proprietari che quelli di terze parti. Se questo viene fatto tra le interazioni con il sito, l'utente apparirà come visitatore per la prima volta al successivo punto di interazione. Senza un ID visitatore unico e persistente, le conversioni, l'analisi del flusso di clic e altre metriche dipendenti dalle attività di un visitatore unico nel tempo non possono essere accurate.

I cookie vengono utilizzati perché gli indirizzi IP non sono sempre univoci per gli utenti e possono essere condivisi da grandi gruppi o proxy. In alcuni casi, l'indirizzo IP viene combinato con l'agente utente al fine di identificare più accuratamente un visitatore se i cookie non sono disponibili. Tuttavia, questo risolve solo parzialmente il problema perché spesso gli utenti dietro un server proxy hanno lo stesso agente utente. Altri metodi per identificare in modo univoco un utente sono tecnicamente impegnativi e limiterebbero il pubblico tracciabile o sarebbero considerati sospetti. I cookie raggiungono il minimo comune denominatore senza utilizzare tecnologie considerate spyware[9].

Metodi di analisi sicuri (misurazione)[modifica | modifica wikitesto]

Potrebbe essere utile essere consapevoli del fatto che la raccolta di informazioni di terze parti è soggetta a limitazioni di rete e sicurezza applicate. Paesi, fornitori di servizi e reti private possono impedire che i dati sulle visite al sito vadano a terze parti. Tutti i metodi sopra descritti (e alcuni altri metodi non menzionati qui, come il campionamento) hanno il problema centrale di essere vulnerabili alla manipolazione (sia inflazione che deflazione). Ciò significa che questi metodi sono imprecisi e insicuri (in qualsiasi ragionevole modello di sicurezza). Questo problema è stato affrontato in una serie di articoli[10][11][12][13], ma le soluzioni suggerite in questi documenti rimangono teoriche, forse per mancanza di interesse da parte della comunità ingegneristica, o per guadagni finanziari che la situazione attuale offre ai proprietari di grandi siti web. Per maggiori dettagli, consultare i suddetti documenti.

Note[modifica | modifica wikitesto]

- ^ (EN) Web analytics, su webopedia.com. URL consultato il 23 marzo 2016.

- ^ (EN) Web Analytics Basics, su usability.gov. URL consultato il 23 marzo 2016.

- ^ (EN) Free Web Analytics Software, su matomo.org. URL consultato il 30 dicembre 2020.

- ^ Jansen, B. J. (2009). Understanding user-web interactions via web analytics. Synthesis Lectures on Information Concepts, Retrieval, and Services, 1(1), 1-102.

- ^ Web Traffic Data Sources and Vendor Comparison Archiviato il 5 settembre 2008 in Internet Archive. by Brian Clifton and Omega Digital Media Ltd

- ^ Marketing Management: A Value-Creation Process (2nd Edition) by Alain Jolibert, Pierre-Louis Dubois, Hans Mühlbacher, Laurent Flores, Pierre-Louis Jolibert Dubois, 2012, p. 359.

- ^ Increasing Accuracy for Online Business Growth - a web analytics accuracy whitepaper

- ^ Rob McGann, Study: Consumers Delete Cookies at Surprising Rate, su clickz.com. URL consultato il 3 aprile 2014.

- ^ Home News Access the Guide Tools Education Shopping Internet Cookies- Spyware or Neutral Technology?, su CNET, February 2, 2005. URL consultato il 24 aprile 2017.

- ^ M. Naor e B. Pinkas, Secure and efficient metering, in Advances in Cryptology — EUROCRYPT'98, Lecture Notes in Computer Science, vol. 1403, 1998, pp. 576, DOI:10.1007/BFb0054155, ISBN 978-3-540-64518-4.

- ^ M. Naor e B. Pinkas, Secure accounting and auditing on the Web, in Computer Networks and ISDN Systems, vol. 30, 1–7, 1998, pp. 541-550, DOI:10.1016/S0169-7552(98)00116-0.

- ^ Matthew K. Franklin e Dahlia Malkhi, Auditable metering with lightweight security, in Financial Cryptography, Lecture Notes in Computer Science, vol. 1318, 1997, pp. 151, DOI:10.1007/3-540-63594-7_75, ISBN 978-3-540-63594-9.

- ^ R. Johnson e J. Staddon, Deflation-secure web metering, in International Journal of Information and Computer Security, vol. 1, 2007, p. 39, DOI:10.1504/IJICS.2007.012244.

Voci correlate[modifica | modifica wikitesto]

Altri progetti[modifica | modifica wikitesto]

Wikimedia Commons contiene immagini o altri file su Web analytics

Wikimedia Commons contiene immagini o altri file su Web analytics

Collegamenti esterni[modifica | modifica wikitesto]

- web analytics, in Lessico del XXI secolo, Istituto dell'Enciclopedia Italiana, 2012-2013.

French

French Deutsch

Deutsch